La corsa a tre per il dominio delle GPU nei data center

La moderna unità di elaborazione grafica (GPU) è nata come acceleratore per i videogiochi, ma negli ultimi 20 anni si è trasformata in un processore server aziendale per applicazioni di calcolo ad alte prestazioni e per l’intelligenza artificiale. Ora le GPU sono alla base delle elevate prestazioni necessarie per l’addestramento dei modelli di IA in ambiti come la ricerca sui farmaci, la modellazione finanziaria e l’imaging medico. Ci sono però anche ambiti di utilizzo più tradizionali in cui le CPU non sono abbastanza veloci, come nei database relazionali basati su GPU. Con l’aumento della domanda di GPU, crescerà anche la concorrenza tra i fornitori che producono GPU per server, ovvero Nvidia, AMD e (presto) Intel.

L’importanza delle GPU nei data center

Questi tre fornitori riconoscono la domanda di GPU nei data center come un’opportunità in crescita. Questo perché le GPU sono più adatte delle CPU per gestire molti dei calcoli richiesti dall’IA e dal machine learning nei data center aziendali e nelle reti hyperscaler. Anche le CPU possono gestire questi carichi di lavoro, ma impiegano molto più tempo a farlo.

Poiché le GPU sono progettate per risolvere complessi problemi matematici in parallelo suddividendoli in attività separate su cui lavorano contemporaneamente, li risolvono più rapidamente. Per raggiungere questo obiettivo, hanno molti più core rispetto alle CPU. Ad esempio, le CPU per server Xeon di Intel hanno fino a 28 core, mentre le CPU per server Epyc di AMD ne hanno fino a 64. Al contrario, l’attuale generazione di GPU di Nvidia (Ampere) ha addirittura 6.912 core, tutti operanti in parallelo per fare una cosa e farla al meglio: elaborazione matematica.

Le prestazioni delle GPU vengono misurate in quante di queste operazioni matematiche a virgola mobile possono eseguire al secondo (FLOPS). Questo numero a volte specifica il formato a virgola mobile standardizzato in uso quando viene eseguita la misura, ad esempio FP64.

Ma esattamente cos’ha in serbo il 2022 per le GPU server? Un bel po’ a quanto pare. Nvidia, AMD e Intel hanno infatti messo le carte in tavola sui loro piani immediati e sembra proprio che assisteremo a una forte competizione.

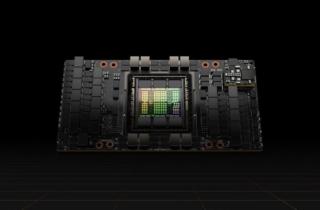

Nvidia

Nvidia ha presentato la sua tabella di marcia per il 2022 a marzo con l’annuncio dell’architettura GPU Hopper che, a seconda dell’uso, può fornire da tre a sei volte le prestazioni della precedente architettura Ampere, ovvero un massimo di 60 TFLOPS a FP64.

Come le GPU precedenti, anche la GPU Hopper H100 può funzionare come processore standalone in esecuzione su una scheda PCI Express aggiuntiva in un server. Ma Nvidia la abbinerà anche a una CPU Arm personalizzata (Grace) che sarà disponibile nel 2023. Per Hopper, Nvidia ha fatto molto di più che potenziare le prestazioni della GPU. Ha infatti modificato anche la memoria LPDDR 5, normalmente utilizzata negli smartphone, per creare la versione LPDDR5X, che supporta il codice di correzione degli errori (ECC) e il doppio della larghezza di banda della memoria rispetto alla memoria DDR5 tradizionale (fino a 1 TBps di throughput).

Oltre all’architettura Hopper, Nvidia ha annunciato NVLink 4, la sua ultima interconnessione GPU-GPU. NVLink 4C2C consente alle GPU Hopper di comunicare direttamente tra esse con una larghezza di banda totale massima di 900 GBs, sette volte più veloce rispetto a un bus PCIe Gen5.

“Se pensate ai prodotti per data center, dovete pensare a tre componenti che devono andare avanti tutti allo stesso ritmo. Parlo di memoria, processore e comunicazioni”, ha affermato Jon Peddie, presidente di Jon Peddie Research. “Solitamente queste tre tecnologie non si muovono in sincronia, ma Nvidia è riuscita a farlo con Hopper”. Nvidia prevede di rendere disponibili le GPU Hopper a partire dal terzo trimestre del 2022. I partner OEM includono Atos, BOXX Technologies, Cisco, Dell Technologies, Fujitsu, GIGABYTE, H3C, Hewlett Packard Enterprise, Inspur, Lenovo, Nettrix e Supermicro.

AMD

Oggi AMD ha il vento alle spalle. Le vendite stanno aumentando di trimestre in trimestre, la sua quota di mercato delle CPU x86 è in crescita e a febbraio ha completato l’acquisizione di Xilinx e dei suoi FPGA, dei suoi SoC adattivi, dei suoi motori di intelligenza artificiale e della sua esperienza in ambito software. Si prevede che AMD lancerà la sua CPU Zen 4 entro la fine del 2022.

AMD ha anche iniziato a distribuire la gamma di GPU Instinct MI250 per l’elaborazione aziendale e si tratta di una gamma notevolmente più veloce rispetto alla precedente serie MI100. Il bus di memoria è raddoppiato da 4096 bit a 8192 bit, la larghezza di banda della memoria è più che raddoppiata a 3,2 TBps da 1,23 TBps e le prestazioni sono più che quadruplicate, passando da 11,5 TFLOPS a 47,9 TFLOPS. Prestazioni ancora lontane da quelle di Hopper con i suoi 60 TFLOPS, ma parliamo comunque di GPU altamente competitive.

Daniel Newman, analista principale di Futurum Research, ha affermato che l’opportunità per AMD di conquistare quote di mercato in ambito data center arriverà con la crescita del mercato dell’IA. Crede inoltre che il successo di AMD nel mercato delle CPU potrebbe aiutare le sue vendite di GPU. “Ciò che AMD ha creato negli ultimi cinque, sette anni è una lealtà piuttosto forte che può eventualmente sfruttare in altri ambiti come quello dell’IA/HPC”

Newman è convinto che AMD possa farcela, visto che si tratta di un’azienda estremamente capace nel trovare opportunità di mercato e nel gestire la sua catena di approvvigionamento per raggiungere i suoi obiettivi. Jonathan Cassell, analista per l’informatica avanzata, l’IA e l’IoT di Omdia, ritiene che il successo di AMD con le sue CPU per server Epyc farà da perfetto apripista per le GPU Instinct.

La gamma AMD Instinct è disponibile dal primo trimestre del 2022. Finora, il suo caso d’uso di più alto profilo è stato con un supercomputer presso gli Oak Ridge National Labs. I partner OEM di MAD in questo settore includono ASUS, ATOS, Dell Technologies, Gigabyte, Hewlett Packard Enterprise (HPE), Lenovo, Penguin Computing e Supermicro.

Intel

Intel ha faticato a lungo per realizzare valide GPU integrate per le sue CPU. Sul versante desktop c’è la nuova gamma Intel Xe, mentre l’equivalente server si chiama Intel Server GPU. Recentemente Intel ha annunciato che entro fine anno entrerà nel mercato delle GPU per data center con un’architettura (nome in codice Ponte Vecchio) capace di fornire 45TFLOPS a FP64, quasi lo stesso valore dell’MI250 di AMD e il 25% in meno di Hopper di Nvidia.

Newman ha sentito cose molto positive su Ponte Vecchio grazie anche alla sua elevata scalabilità, ma secondo lui la vera opportunità per Intel è oneAPI, una piattaforma di sviluppo software unificante progettata per scegliere il tipo più appropriato di architettura Intel (x86, GPU, FPGA, processori AI) durante la compilazione di applicazioni, anziché costringere lo sviluppatore a scegliere un tipo di architettura e scrivere codice per essa. OneAPI fornisce inoltre una serie di librerie API per funzioni avanzate come elaborazione video, comunicazioni, analisi e reti neurali.

Questa astrazione elimina la necessità di determinare il miglior processore su cui puntare, così come la necessità di lavorare con diversi strumenti, librerie e linguaggi di programmazione. Quindi, anziché codificare su un processore specifico in un linguaggio specifico, gli sviluppatori possono concentrarsi sulla logica aziendale e scrivere in Data Parallel C++ (DPC++), una variante open source di C++ progettata specificamente per il parallelismo dei dati e la programmazione eterogenea.

Un fattore importante che avvantaggia Intel rispetto a Nvidia e AMD è dove produce i suoi chip. Mentre le altre due aziende si affidano al fornitore di chip taiwanese TSMC, Intel produce molti dei propri chip negli Stati Uniti, con altre fabbriche in Irlanda, Malesia e Israele (e ha grandi progetti per costruirne altre negli USA). Ciò conferisce a Intel alcuni innegabili vantaggi, ha detto Cassell. “Il controllo che ha sulla propria produzione fornisce a Intel anche il controllo sul proprio destino e la vedo come una risorsa molto importante a cui attingere”.

Infine, secondo Newman, la competizione tra Nvidia, AMD e Intel potrebbe giocarsi in ultima istanza sul versante software. “I migliori ingegneri di Nvidia vi diranno che non lavorano per un produttore di chip ma per una società specializzata in software. E credo che Intel, se si giocherà la carta oneAPI nel modo giusto, riuscirà a ottenere parecchia influenza nel mercato delle GPU per data center”.