Nutanix GPT-in-a-box si aggiorna con nuovi framework e modelli

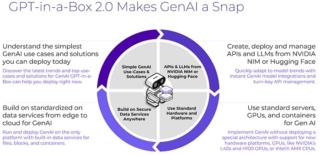

Nutanix ha presentato nuove funzionalità per Nutanix GPT-in-a-Box, inclusa l’integrazione con i microservizi di inferenza NVIDIA NIM e con la libreria Large Language Models (LLM) di Hugging Face. Nutanix GPT-in-a-Box è una soluzione full-stack creata appositamente per semplificare l’adozione dell’IA nelle aziende.

Nutanix GPT-in-a-Box 2.0, che sarà disponibile nella seconda metà del 2024, offre un supporto più esteso all’elaborazione accelerata di NVIDIA e agli LLM, oltre a una gestione semplificata dei modelli di base e a piena integrazione con i microservizi NVIDIA NIM e la libreria LLM Hugging Face. Include inoltre un’interfaccia utente unificata per la gestione dei modelli fondamentali, la creazione di endpoint API, la gestione delle chiavi di accesso dell’utente e l’integrazione di Nutanix Files and Objects, oltre alle GPU NVIDIA Tensor Core.

La partnership con Hugging Face contribuirà ad accelerare il percorso di adozione dell’IA da parte dei clienti, fornendo accesso integrato alla libreria di Hugging Face e all’esecuzione di LLM per i clienti Nutanix. I clienti comuni potranno sfruttare Nutanix GPT-in-a-Box 2.0 per utilizzare facilmente gli LLM convalidati da Hugging Face ed eseguirli in modo efficiente.

Grazie a questa partnership, Nutanix e Hugging Face svilupperanno un’integrazione personalizzata con Text Generation Inference, la libreria open-source di Hugging Face per l’implementazione in produzione di LLM, e renderanno disponibili i modelli di generazione del testo sull’hub di Hugging Face all’interno di Nutanix GPT-in-a-Box 2.0. Il sistema offrirà un flusso di lavoro continuo per la distribuzione di LLM IA convalidati da Hugging Face con il pieno supporto di Nutanix, in modo da creare un flusso di lavoro convalidato e supportato congiuntamente per le librerie e gli LLM di Hugging Face garantendo ai clienti un unico punto di gestione per l’inferenza coerente dei modelli.

Nutanix ha inoltre potenziato la sua piattaforma di dati non strutturati per IA/ML e altre applicazioni con prestazioni, densità e TCO superiori. Nutanix Unified Storage (NUS) supporta ora una nuova piattaforma all-NVMe da oltre 550 Terabyte e un throughput di lettura sequenziale fino a 10 Gigabyte/secondo da un singolo nodo (quasi la velocità di una porta ethernet da 100 Gigabit), consentendo letture di dati più rapide e un uso più efficiente delle risorse delle GPU.

Nutanix offrirà inoltre il supporto per NVIDIA GPUDirect Storage per velocizzare ulteriormente le applicazioni IA/ML e, per proteggere i dati di importanza strategica e spesso riservati come i set di dati utilizzati per l’addestramento e l’elaborazione dei carichi di lavoro IA/ML, Nutanix Data Lens estende la protezione agli oggetti oltre che ai dati dei file. Un nuovo punto di accesso di Data Lens a Francoforte consente una più ampia adozione da parte dei clienti dell’UE, soddisfacendo le loro esigenze di conformità.

Questi gli altri annunci di Nutanix

- Collaborazione con i principali OEM di server per offrire ai clienti un’ampia scelta con una vasta gamma di GPU ottimizzate per l’IA e di sistemi GPU ottimizzati per la densità. Queste GPU ottimizzate per l’IA, tra cui le NVIDIA L40S, H100, L40 e L4, sono oggi supportate da Nutanix GPT-in-a-Box

- Supporto dei sistemi di GPU ottimizzati per la densità di Dell, HPE e Lenovo al fine di ridurre il TCO, consentendo ai clienti di implementare un numero inferiore di sistemi per soddisfare le loro esigenze in termini di carichi di lavoro

- Supporto di NX-9151 basato sull’architettura di riferimento NVIDIA MGX