Le Cloud GPU Nvidia più adatte per la IA e le applicazioni di super calcolo

Indice dell'articolo

Molte delle applicazioni più innovative in ambito aziendale oggi richiedono una potenza di calcolo che solo le GPU più avanzate e specializzate sono in grado di erogare. Non tutte le applicazioni però hanno lo stesso tipo di esigenze. L’addestramento di un modello IA ha requisiti tecnici diversi dall’analisi di flussi video, o dalla simulazione finanziaria. E anche all’interno dello stesso dominio, i carichi di lavoro possono variare molto nel tempo.

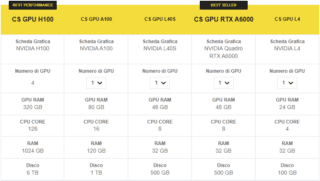

Anche le GPU non sono tutte uguali, e ciascuna ha dei campi di applicazioni nei quali può esprimere il meglio nella combinazione tra costo, prestazioni e consumi energetici. E visto che le GPU più avanzate hanno un costo elevato – non stiamo parlando delle schede video dedicate, ma di interi GPU server – e una disponibilità intermittente sul mercato, una delle opzioni più efficaci sul mercato per unire velocità di implementazione e contenimento dei costi è ricorrere ai servizi di Cloud GPU, come quelli offerti da Seeweb.

Il ricorso alle GPU in cloud e al modello as-a-service in cui si paga un costo orario solo per l’effettivo utilizzo ha anche un ulteriore vantaggio: è possibile scegliere per ogni tipo di workload la GPU più appropriata, selezionando il server dal ricco catalogo di Seeweb. Per esempio, il Cloud Server GPU con le più potenti schede Nvidia H100 per la fase di addestramento di un modello, per poi passare nella fase di esecuzione ordinaria del modello all’interno di un’applicazione (detta fase di inferenza) a server con schede correttamente dimensionate per quel compito, come la Nvidia L4 o L40S, con un costo che un decimo di quello delle H100.

In questo articolo vedremo quali sono le caratteristiche distintive delle diverse classi di server GPU Nvidia, e quali sono le più adatte ai compiti più comuni di high performance computing che richiedono il calcolo parallelo e le prestazioni che queste schede possono offrire.

GPU per IA e calcolo ad alte prestazioni: le caratteristiche che contano

Le GPU moderne sono altamente specializzate, progettate per gestire carichi di lavoro paralleli intensivi. La loro architettura è ottimizzata non solo per la grafica, ma anche per calcoli scientifici, intelligenza artificiale e altre applicazioni ad alte prestazioni. Le caratteristiche chiave di una GPU includono i suoi core di elaborazione, la memoria, e varie unità specializzate. Al giorno d’oggi, l’architettura di riferimento è senza dubbio quella di Nvidia, e ad essa faremo riferimento nel resto dell’articolo.

I diversi core delle GPU

Il cuore di una GPU Nvidia è costituito dai CUDA core, progettati per il calcolo parallelo. Sono organizzati in Streaming Multiprocessors (SM) e sono responsabili della maggior parte dei calcoli generici. Oltre ai CUDA core, le GPU moderne includono anche unità specializzate come i Tensor Core, progettati per le operazioni matriciali tipiche del machine learning, e gli RT Core, dedicati al ray tracing in tempo reale per la grafica avanzata. Il numero e l’efficienza dei diversi core determina quindi la vocazione dei diversi modelli di GPU verso un tipo di applicazione o l’altra.

La memoria delle GPU

La memoria dedicata della GPU gioca un ruolo cruciale nelle prestazioni. Le GPU high-end utilizzano memorie ad alta larghezza di banda come HBM2 o HBM3, che offrono velocità di trasferimento dati estremamente elevate. La quantità di memoria disponibile determina la dimensione dei dataset che possono essere elaborati efficacemente senza dover ricorrere a frequenti trasferimenti dalla memoria del sistema a quella della GPU, e viceversa.

A proposito di banda nello scambio dei dati, per applicazioni che richiedono l’uso di più GPU contemporaneamente, l’interconnessione tra le unità diventa fondamentale. Tecnologie come NVLink di Nvidia offrono collegamenti ad alta velocità tra GPU, consentendo una collaborazione efficiente su compiti complessi.

Come leggere i benchmark delle GPU

Le prestazioni delle GPU sono spesso misurate in termini di FLOPS (Floating Point Operations Per Second) e TOPS (Tensor Operations Per Second). I FLOPS indicano quante operazioni in virgola mobile una GPU può eseguire al secondo e sono generalmente specificati per diversi livelli di precisione, indicando il numero di bit che esprimono il valore: FP32 (precisione singola), FP64 (doppia precisione) e FP16 (mezza precisione). La potenza delle schede attuali è così elevata che le prestazioni sono misurate in Tera FLOPS, cioè migliaia di miliardi di operazioni in virgola mobile al secondo.

I TOPS, invece, si riferiscono specificamente alle prestazioni dei Tensor Core nelle operazioni matriciali, cruciali per il machine learning.

Un altro aspetto importante è la capacità di eseguire operazioni su numeri interi (INT) e la cosiddetta quantizzazione. Le operazioni INT sono fondamentali per molte applicazioni, compresa la crittografia. La quantizzazione è invece una tecnica che riduce la precisione dei calcoli (ad esempio da FP32 a INT8 o addirittura INT4) per aumentare l’efficienza computazionale e ridurre i consumi energetici, opzioni particolarmente utili nell’inferenza di modelli di intelligenza artificiale. Questa tecnica permette di raggiungere prestazioni molto elevate in termini di TOPS, specialmente per operazioni a bassa precisione, accelerando significativamente certi tipi di carichi di lavoro pur mantenendo un’accuratezza accettabile.

Le GPU più adatte per i diversi carichi di lavoro moderni

Alla luce di queste considerazioni, vediamo quindi quali sono le caratteristiche computazionali dei diversi tipi di workload moderni, dal machine learning all’analisi di big data, dal calcolo scientifico all’analisi di video, come queste si traducano in requisiti hardware e, infine, quali GPU Nvidia tra quelle offerte nel servizio Cloud Server GPU di Seeweb sono le più indicate.

Addestramento di modelli IA: requisiti e GPU consigliata

L’addestramento di modelli IA richiede l’analisi di enormi quantità di dati e il calcolo di milioni di parametri. Questo processo comporta operazioni matriciali intensive e ripetitive. Le GPU ad alte prestazioni con molti CUDA core e Tensor core specializzati sono essenziali per accelerare questi calcoli. La grande quantità di memoria ad alta larghezza di banda è necessaria per gestire i dataset e i modelli di grandi dimensioni, riducendo i trasferimenti di dati e migliorando l’efficienza complessiva.

Requisiti hardware: Elevato numero di CUDA core (8000 o più), Tensor core per accelerazione di calcoli matriciali, 32-64 GB di memoria HBM2/HBM3

Prestazioni richieste: da 20 a più di 100 TFLOPS in FP32, a seconda delle dimensioni del modello

GPU consigliate: NVIDIA A100 o H100

Inferenza di modelli IA: requisiti e GPU consigliate

L’inferenza IA richiede l’esecuzione rapida di modelli pre-addestrati su nuovi dati. Sebbene meno intensiva dell’addestramento, l’inferenza beneficia di GPU ottimizzate per operazioni a bassa precisione (INT8/INT4) che accelerano i calcoli. La quantizzazione riduce la precisione numerica, consentendo elaborazioni più veloci ed efficienti dal punto di vista energetico, cruciali per applicazioni in tempo reale e ad alto throughput. Sarà in ogni caso necessario bilanciare il livello di quantizzazione, e quindi la maggiore velocità ed efficienza, con un livello minimo accettabile di accuratezza dei risultati.

Requisiti hardware: Minore numero di CUDA core rispetto all’addestramento (3000-5000), Tensor core e INT8/INT4 per quantizzazione, 16-32 GB di memoria

Prestazioni richieste: 200+ TOPS in INT8

GPU consigliate: NVIDIA L4 o L40S

Calcolo scientifico: requisiti e GPU consigliate

Il calcolo scientifico spesso richiede simulazioni complesse e calcoli ad alta precisione. L’uso di FP64 è fondamentale per mantenere l’accuratezza in calcoli iterativi dove gli errori di arrotondamento possono accumularsi. L’elevato numero di CUDA core e la grande quantità di memoria ad alta larghezza di banda sono necessari per gestire dataset molto grandi e modelli matematici complessi, consentendo simulazioni dettagliate in campi come la fisica delle particelle, la dinamica dei fluidi e l’astrofisica.

Requisiti hardware: Alto numero di CUDA core (5000+), supporto per calcoli in doppia precisione (FP64), 32-80 GB di memoria HBM2/HBM3

Prestazioni richieste: 8-10 TFLOPS in FP64

GPU consigliate: NVIDIA A100 o H100

Finanza computazionale: requisiti e GPU consigliate

La finanza computazionale richiede un mix di alta precisione per i calcoli critici (come il pricing di derivati complessi) e bassa latenza per operazioni in tempo reale nel caso del trading algoritmico. Il supporto dei calcoli FP64 garantisce l’accuratezza nei calcoli finanziari sensibili, mentre la bassa latenza è cruciale per eseguire analisi e prendere decisioni rapidamente in mercati molto volatili. La memoria ampia consente di gestire grandi set di dati finanziari e modelli complessi simultaneamente.

Requisiti hardware: Bilanciamento tra CUDA core (4000-6000) e memoria, supporto per FP64 e bassa latenza, 24-48 GB di memoria

Prestazioni richieste: 5 TFLOPS in FP64

GPU consigliate: NVIDIA A100

Grafica 3D e rendering video: requisiti e GPU consigliate

La grafica 3D e il rendering video richiedono un’intensa elaborazione per creare immagini fotorealistiche e animazioni fluide. I core RT accelerano il ray tracing, simulando il comportamento fisico della luce per un realismo superiore. I Tensor core supportano il DLSS (Deep Learning Super Sampling), che usa l’IA per fare upscaling delle immagini a bassa risoluzione, migliorando la qualità visiva con minor costo computazionale. Una memoria capiente è essenziale per gestire texture ad alta risoluzione e scene complesse.

Requisiti hardware: Numero medio di CUDA core (4000 o più), RT core per ray tracing, Tensor core per DLSS, 24-48 GB di memoria

Prestazioni richieste: 40+ TFLOPS in FP32

GPU consigliate: NVIDIA RTX A6000 o L40S

Bioinformatica e analisi genomica: requisiti e GPU consigliate

La bioinformatica e l’analisi genomica comportano l’elaborazione di enormi dataset genetici e l’esecuzione di algoritmi complessi per l’allineamento di sequenze, l’assemblaggio di genomi e l’analisi filogenetica. Queste operazioni richiedono un equilibrio tra potenza di calcolo e memoria. I CUDA core gestiscono i calcoli paralleli per l’analisi delle sequenze, mentre l’ampia memoria permette di caricare e manipolare grandi dataset genomici, riducendo la necessità di accessi frequenti al disco e accelerando l’analisi complessiva.

Requisiti hardware: Bilanciamento tra CUDA core (3000-5000) e memoria (24-48 GB)

Prestazioni richieste: 30 TFLOPS in FP32

GPU consigliate: NVIDIA A100 o L40S

Simulazioni di dinamica dei fluidi: requisiti e GPU consigliate

Le simulazioni di dinamica dei fluidi richiedono calcoli intensivi per modellare il comportamento di liquidi e gas in varie condizioni. L’alta precisione (FP64) è cruciale per mantenere l’accuratezza in calcoli iterativi complessi che simulano il movimento delle particelle fluide. L’elevato numero di CUDA core consente di parallelizzare questi calcoli su milioni di punti della griglia di simulazione. La grande quantità di memoria è necessaria per gestire i dati volumetrici 3D e le strutture dati complesse utilizzate in queste simulazioni.

Requisiti hardware: Alto numero di CUDA core (5000+), supporto per FP64, 32-80 GB di memoria

Prestazioni richieste: 8+ TFLOPS in FP64

GPU consigliate: NVIDIA A100 o H100

Crittografia e sicurezza informatica: requisiti e GPU consigliate

La crittografia e la sicurezza informatica spesso coinvolgono operazioni intensive su numeri interi di grandi dimensioni e calcoli modulari. Le GPU con buone prestazioni in operazioni integer sono ideali per compiti come la generazione di chiavi, la firma digitale e l’hashing. La parallelizzazione offerta dai CUDA core accelera significativamente questi processi, permettendo di processare grandi volumi di dati per il rilevamento di anomalie in tempo reale.

Requisiti hardware: Medio numero di CUDA core (3000-4000), supporto per operazioni integer, 16-24 GB di memoria

Prestazioni richieste: 150 TOPS in INT8

GPU consigliate: NVIDIA L4

Analisi di big data e data mining: requisiti e GPU consigliate

L’analisi di big data e il data mining richiedono l’elaborazione di enormi volumi di dati strutturati e non strutturati. Le GPU con un alto numero di CUDA core possono parallelizzare efficacemente operazioni come il clustering, la classificazione e l’analisi delle correlazioni su grandi dataset. L’ampia memoria è cruciale per mantenere grandi porzioni di dati in GPU, riducendo i costosi trasferimenti di dati e accelerando l’analisi. Le alte prestazioni in FP32 sono importanti per mantenere la precisione in calcoli statistici complessi.

Requisiti hardware: Medio-alto numero di CUDA core (4000-6000), 24-48 GB di memoria

Prestazioni richieste: 40 TFLOPS in FP32

GPU consigliate: NVIDIA A100 o L40S

Elaborazione del linguaggio naturale su larga scala: requisiti e GPU consigliate

L’elaborazione del linguaggio naturale su larga scala, soprattutto con modelli transformer come GPT, richiede enormi risorse computazionali. I modelli linguistici di grandi dimensioni contengono miliardi di parametri che devono essere elaborati in parallelo. L’alto numero di CUDA core e i Tensor core specializzati accelerano le operazioni matriciali intensive tipiche di questi modelli. La grande quantità di memoria ad alta larghezza di banda è essenziale per gestire i pesi del modello e i dati di input/output, consentendo l’elaborazione efficiente di lunghe sequenze di testo.

Requisiti hardware: Alto numero di CUDA core (6000+), Tensor core, 32-80 GB di memoria

Prestazioni richieste: 100+ TFLOPS in FP32

GPU consigliate: NVIDIA A100 o H100

Computer vision ed elaborazione di immagini/video: requisiti e GPU consigliate

La computer vision e l’elaborazione di immagini o video richiedono l’applicazione di complessi algoritmi su grandi volumi di dati che descrivono immagini. I CUDA core permettono di parallelizzare operazioni come il filtraggio, la segmentazione e il riconoscimento di oggetti. I Tensor core accelerano le operazioni di convoluzione nelle reti neurali convoluzionali (CNN) ampiamente utilizzate nella visione artificiale. L’ampia memoria è necessaria per gestire video ad alta risoluzione o per elaborare in batch un grande numero di immagini, consentendo una resa efficiente senza frequenti trasferimenti di dati.

Requisiti hardware: Medio-alto numero di CUDA core (4000-6000), Tensor core, 24-48 GB di memoria

Prestazioni richieste: 40+ TFLOPS in FP32

GPU consigliate: NVIDIA L40S o RTX A6000

Modellazione climatica e previsioni meteorologiche: requisiti e GPU consigliate

La modellazione climatica e le previsioni meteorologiche richiedono simulazioni estremamente complesse che integrano vari fattori fisici su scale spaziali e temporali molto ampie. L’uso di FP64 è cruciale per mantenere la precisione in calcoli iterativi che modellano l’atmosfera e gli oceani. L’alto numero di CUDA core permette di parallelizzare i calcoli su griglie tridimensionali che rappresentano l’atmosfera terrestre. La grande quantità di memoria è necessaria per gestire i vasti dataset che includono temperature, pressioni, umidità e altri parametri atmosferici su scala globale.

Requisiti hardware: Alto numero di CUDA core (5000+), supporto per FP64, 32-80 GB di memoria

Prestazioni richieste: 8+ TFLOPS in FP64

GPU consigliate: NVIDIA A100 o H100

Progettazione assistita da computer (CAD) e simulazioni ingegneristiche: requisiti e GPU consigliate

La progettazione CAD e le simulazioni ingegneristiche richiedono una combinazione di potenza di calcolo per le simulazioni fisiche e capacità grafiche per il rendering in tempo reale di modelli complessi. I CUDA core gestiscono i calcoli paralleli per simulazioni strutturali, termiche o fluidodinamiche. I RT core migliorano il rendering realistico dei modelli 3D, cruciale per la visualizzazione e l’analisi dei risultati. L’ampia memoria consente di gestire assemblati complessi e grandi dataset di simulazione, permettendo agli ingegneri di lavorare su progetti dettagliati senza compromessi sulle prestazioni.

Requisiti hardware: Medio-alto numero di CUDA core (4000-6000), RT core per ray tracing, 24-48 GB di memoria

Prestazioni richieste: 40+ TFLOPS in FP32

GPU consigliate: NVIDIA RTX A6000 o L40S

Realtà virtuale e aumentata: requisiti e GPU consigliate

La realtà virtuale e aumentata richiede la generazione di immagini ad alta risoluzione e bassa latenza per creare un’esperienza immersiva e confortevole. I CUDA core gestiscono il rendering generale, mentre i core RT migliorano il realismo attraverso il ray tracing in tempo reale. I Tensor core supportano tecniche di AI come il DLSS per migliorare la qualità dell’immagine mantenendo alte prestazioni. L’ampia memoria è necessaria per gestire texture ad alta risoluzione, modelli 3D complessi e dati di tracking in tempo reale. La potenza di calcolo elevata assicura frame rate stabili e alte risoluzioni, cruciali per prevenire la nausea da movimento e garantire all’utente un’esperienza fluida.

Requisiti hardware: Medio-alto numero di CUDA core (4000-6000), RT core per ray tracing, Tensor core per DLSS, 24-48 GB di memoria

Prestazioni richieste: 40+ TFLOPS in FP32

GPU consigliate: NVIDIA RTX A6000 o L40S

Conclusioni: la Cloud GPU giusta per il tuo progetto

Come abbiamo visto, le variabili in gioco sono diverse e richiedono in alcuni casi competenze specializzate per l’individuazione dell’hardware più appropriato per i diversi carichi di lavoro. Il bello del cloud computing, anche nel caso in cui riguardi i GPU Server, è che è possibile fare esperimenti e cambiamenti nella configurazione hardware senza rischiare di fare un investimento sbagliato per l’acquisto di hardware.

Gli specialisti di Seeweb possono poi fornire aiuto e consulenza sia nella fase di selezione del prodotto più appropriato, sia nella sua configurazione più corretta in base all’applicazione che dovrà eseguire.

Per ulteriori informazioni sui servizi di Cloud GPU di Seeweb, fai clic qui