Meta lancia Movie Gen, generatore AI di video fotorealistici, con audio

Meta ha annunciato il lancio di Movie Gen, una suite di modelli di intelligenza artificiale generativa rivolta a filmmaker professionisti e a content creator amatoriali per la creazione e l’editing di contenuti video e audio.

Movie Gen si distingue per quattro capacità principali:

- Generazione video: Utilizza un modello da 30 miliardi di parametri per creare video di alta qualità basati su prompt testuali fino a 16 secondi e 16 frame al secondo (fps)

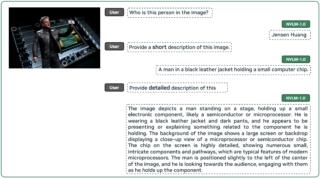

- Video personalizzati: Combina un’immagine di riferimento di una persona con un prompt testuale per generare video che mantengono l’identità e il movimento del soggetto

- Editing video di precisione: Consente modifiche ai video esistenti come l’aggiunta, la rimozione o la sostituzione di elementi, preservando al tempo stesso il contenuto originale non interessato dalle modifiche

- Generazione audio: Impiega un modello da 13 miliardi di parametri per creare audio di alta qualità fino a un massimo di 45 secondi sincronizzato con il contenuto video, inclusi effetti sonori e musica di sottofondo

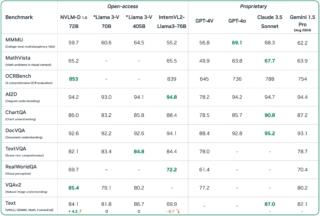

Meta sottolinea che Movie Gen supera le prestazioni di modelli simili presenti sul mercato in tutte queste aree, come dimostrato da valutazioni umane comparative. L’azienda posiziona Movie Gen come parte di una strategia di lungo termine nel campo dell’IA generativa, seguendo i precedenti rilasci delle serie Make-A-Scene e Llama Image.

Pur riconoscendo il potenziale trasformativo di questa tecnologia, Meta chiarisce nell’annuncio di Movie Gen che l’IA generativa non intende sostituire il lavoro di artisti e animatori. Piuttosto, l’obiettivo è democratizzare gli strumenti creativi, permettendo a un pubblico più ampio di esprimere le proprie visioni artistiche attraverso video e audio di alta definizione.

Meta evidenzia anche alcune limitazioni attuali dei modelli, in particolare riguardo ai tempi di inferenza e alla qualità complessiva, indicando che ci sono margini di miglioramento attraverso ulteriori ottimizzazioni e scaling.

Guardando al futuro, l’azienda prevede di collaborare strettamente con filmmaker e creatori per integrare il loro feedback nello sviluppo di questi strumenti. Meta prospetta scenari d’uso come l’animazione e l’editing di video per i social media o la creazione di auguri personalizzati, sottolineando le infinite possibilità offerte da questa tecnologia.