Mistral AI rilascia nuove API per la moderazione dei contenuti in più lingue, tra cui l’italiano

La sicurezza è un elemento chiave per rendere l’IA davvero utile e la startup francese Mistral AI ritiene che sia fondamentale implementare sistemi di protezione robusti per garantire un utilizzo sicuro delle applicazioni IA. Per questo motivo, ha lanciato una nuova API per la moderazione dei contenuti, la stessa utilizzata nel servizio di moderazione di Le Chat. Questa API è ora disponibile per consentire agli utenti di adattarla e personalizzarla in base alle proprie esigenze applicative e standard di sicurezza.

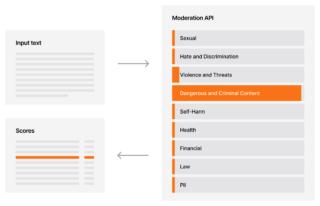

Il modello sviluppato da Mistral AI è un classificatore LLM capace di suddividere i testi in 9 categorie diverse. Vengono offerti due endpoint per l’uso dell’API: uno per analizzare testi generici e uno specifico per contenuti conversazionali. Poiché i contenuti indesiderati variano a seconda del contesto, il modello è stato addestrato a classificare l’ultimo messaggio di una conversazione nel contesto di una chat. Il modello, inoltre, è multilingue, con addestramento specifico per diverse lingue tra cui arabo, cinese, inglese, francese, tedesco, italiano, giapponese, coreano, portoghese, russo e spagnolo.

Il classificatore di moderazione dei contenuti si basa su categorie di policy rilevanti, introducendo un approccio pratico alla sicurezza dei modelli LLM e affrontando problematiche come la generazione di consigli non qualificati e la protezione delle informazioni personali (PII).

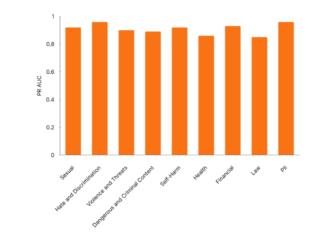

Per quanto riguarda le prestazioni, Mistral AI ha condiviso i risultati di test interni (immagine sotto) utilizzando l’AUC PR come metrica di valutazione delle performance su diverse categorie di policy. Il focus è sull’efficacia delle guardrail di sicurezza, cioè quei meccanismi di controllo che impediscono comportamenti indesiderati da parte dei modelli di IA.

Mistral AI ha inoltre introdotto l’API batch, disponibile da oggi su La Plateforme. L’API batch introduce un modo più efficiente per elaborare richieste di volumi elevati ai modelli Mistral a un costo inferiore del 50% rispetto a quello di una chiamata API sincrona. Per chi sta realizzando applicazioni di intelligenza artificiale in cui dare priorità al volume di dati rispetto alle risposte sincrone, l’API batch può essere la soluzione ideale. È sufficiente caricare il file batch e, una volta elaborate le richieste, scaricare e utilizzare il file di output.

Le applicazioni più diffuse per l’API batch includono il feedback dei clienti e l’analisi del sentiment, la sintesi e la traduzione di documenti in blocco, l’integrazione di vettori per preparare gli indici di ricerca e l’etichettatura dei dati. L’API batch è disponibile per tutti i modelli serviti su la Plateforme e presto anche per i partner cloud provider, con il tasso di utilizzo limitato a 1 milione di richieste in corso per spazio di lavoro.