Con gli LLM in stallo, Meta punta sui Large Concept Model?

Dal lancio di ChatGPT nel 2022, l’era dell’IA generativa ha preso il sopravvento, rendendo i modelli linguistici di grandi dimensioni (LLM) centrali nella nostra quotidianità. Tuttavia, molti esperti del settore hanno recentemente suggerito che la crescita di questi modelli stia rallentando e, in risposta a ciò, Meta propone una soluzione innovativa: i Large Concept Model (LCM).

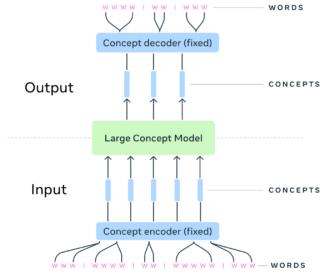

Gli LCM rappresentano un approccio rivoluzionario alla modellazione del linguaggio, spostandosi dal livello token, tipico degli LLM, a un livello concettuale più astratto. Invece di analizzare testo parola per parola, gli LCM operano con “concetti”, ossia rappresentazioni agnostiche rispetto alla lingua e al formato, che descrivono idee o azioni di livello superiore.

Nel contesto degli LCM, un concetto è definito come un’idea atomica e astratta, spesso corrispondente a una frase o a un’espressione completa. Questo permette al modello di ragionare in modo semantico e indipendente dal formato di input, che può essere testo, audio o immagini.

LLM vs LCM

I tradizionali modelli linguistici, come ChatGPT, prevedono le parole successive in base a quelle precedenti, costruendo il testo passo dopo passo. Gli LCM, invece, prevedono il prossimo concetto, ragionando su intere frasi o idee. Questo approccio consente una visione globale del discorso, migliorando coerenza e pianificazione narrativa.

Le caratteristiche chiave degli LCM possono essere riassunte in quattro aspetti:

- Indipendenza linguistica: Gli LCM trattano frasi con significato equivalente in lingue diverse come lo stesso concetto

- Multimodalità: Il modello comprende testo, audio e immagini, associando ad esempio una frase come “Il gatto ha fame” a una foto di un gatto affamato

- Efficienza nei contesti estesi: Elaborando sequenze di concetti invece che di parole, gli LCM gestiscono meglio contesti lunghi rispetto agli LLM

- Generalizzazione zero-shot: Grazie alla rappresentazione concettuale, possono lavorare su lingue o modalità non specificatamente addestrate

Gli LCM utilizzano SONAR, un sistema di embedding multilingue e multimodale, per rappresentare frasi come vettori semantici. SONAR supporta 200 lingue testuali e 76 linguistiche vocali e, durante il training, Meta ha esplorato tecniche come i modelli di diffusione per prevedere i prossimi concetti.

In ottica futura, se gli LLM restano ottimi per compiti come completamento testuale e traduzione, gli LCM sono destinati a brillare in attività più complesse come sintesi, generazione di storie e ragionamento multimodale. Meta punta proprio su questi modelli per offrire interazioni più naturali e intuitive, aprendo nuove possibilità nei settori educativi, creativi e dell’intrattenimento e facendo segnare una svolta significativa, in cui l’intelligenza artificiale si sposterà verso livelli di astrazione sempre più vicini al pensiero umano.

Nonostante le promesse invitanti, alcune scelte progettuali comportano compromessi significativi, come si può vedere da questi limiti:

- Il modello privilegia frasi brevi e informali, come quelle dei social media, limitando la sua capacità di gestire testi complessi o strutturati, come articoli accademici o documenti legali

- Operando solo a livello di frase, l’LCM manca di precisione nei dettagli semantici e sintattici, penalizzando compiti come il riconoscimento di entità o l’analisi di testi tecnici

- Gli LCM sono stati testati principalmente in attività di riassunto, trascurando applicazioni più complesse come classificazione di documenti, generazione di dialoghi o ragionamento logico

- Modellando le frasi come concetti isolati, l’LCM fatica a mantenere coerenza nei testi estesi, come racconti o rapporti complessi

Ecco perché diversi esperti vedono all’orizzonte possibili miglioramenti, come integrare interazioni a livello di token per maggiore granularità, ampliare i compiti di valutazione includendo testi lunghi e dialoghi, adottare meccanismi di memoria per gestire contesti più ampi e consentire il fine-tuning degli embedding per domini specifici.