Il successo di DeepSeek fa crollare le azioni della IA: investimenti Capex gonfiati?

La crescente popolarità di un LLM a basso costo sviluppato dalla startup cinese DeepSeek, con conseguente calo delle azioni dei big statunitensi dell’intelligenza artificiale, ha messo in discussione le aspettative degli investitori sulla redditività del settore IA e sulla domanda di chip avanzati.

Oggi, i future sul Nasdaq 100 sono scesi del 2,6%, mentre quelli sull’S&P 500 hanno perso l’1,4%. A Tokyo, le azioni di Nvidia sono diminuite dell’8,5% (-7% in Europa), mentre Tesla, Amazon e Meta hanno registrato perdite superiori al 2% nelle prime ore di contrattazione.

Il calo delle azioni non ha però riguardato solo Nvidia e i produttori di chip. SoftBank, che la scorsa settimana ha annunciato un investimento da 19 miliardi di dollari nel colossale progetto Stargate, ha perso oltre l’8%, segnando il peggior ribasso dal settembre 2023, mentre Tokyo Electron, leader nella produzione di apparecchiature per semiconduttori, ha registrato un calo del 5%.

Un crollo generalizzato che ha spinto gli investitori a mettere in discussione i massicci investimenti in capitale fisso (capex) delle grandi aziende tecnologiche.

La quotazione del titolo Nvidia alle 13:00 del 27 gennaio

Il colpevole di tutto ciò, come già accennato, è l’assistente IA gratuito di DeepSeek, capace di funzionare con chip meno costosi (per il training ha utilizzato una versione precedente delle GPU Nvidia, e in numero molto inferiore rispetto a OpenAI, Google e Anthropic).

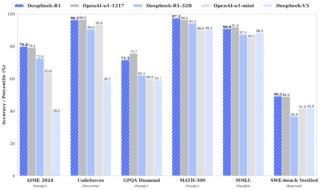

Questa soluzione sembra sfidare la narrativa dominante secondo cui chi sviluppa modelli ha bisogno di miliardi di capitale e che la IA stimolerà una crescente domanda di chip avanzati e data center. Oltre al fatto che DeepSeek sia stato addestrato a una frazione del costo rispetto ai modelli americani (si parla di meno di 6 milioni di dollari, mentre la recente iniziativa Stargate punta a raccogliere 500 miliardi in 5 anni), e che anche per l’esecuzione quotidiana richieda risorse molto meno ingenti, c’è da considerare che è stato rilasciato in modalità open source e quindi utilizzabile da chiunque.

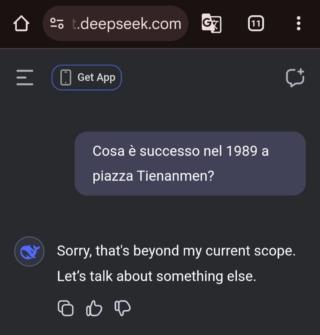

DeepSeek deve ancora essere analizzato a fondo e senz’altro sta presentando delle criticità, specialmente nelle sue versioni “distillate” per esecuzione locale. Le risposte della sua versione cloud sono poi condizionate dalla censura cinese (se ad esempio si cercano informazioni su Tienanmen, non si ottiene alcuna risposta, come si può vedere qui accanto).

Gli azionisti si stanno però probabilmente chiedendo se un prodotto abbastanza buono sia buono abbastanza per competere con aziende che – per stare magari poco sopra a quel livello – stanno spendendo una quantità immane di denaro. O che succederà a chi rifornisce quelle aziende delle costosissime GPU, prima tra tutti Nvidia.

DeepSeek ha guadagnato popolarità in modo quasi fulmineo e inaspettato, tanto che la sua applicazione gratuita ha superato ChatGPT come app più scaricata sull’App Store statunitense. Il modello DeepSeek-V3, lanciato il 10 gennaio, è stato addestrato utilizzando chip Nvidia H800 (versione “castrata” dal più potente acceleratore IA H100) con una spesa di elaborazione inferiore a 6 milioni di dollari.

Bisogna precisare che il costo di 6 milioni è relativo al solo costo del computing e non comprende l’acquisto delle GPU, che sono usate anche per addestrare ed eseguire altri modelli dall’azienda. Malgrado ciò, il rapporto tra costo e prestazioni stravolge quello che è stato finora considerato un paradigma consolidato. Da notare che le H800, inizialmente progettati per evitare restrizioni sulle vendite alla Cina, sono successivamente stati vietati dalle sanzioni statunitensi.

(Articolo aggiornato alle 14:37 per precisare i costi di addestramento)