Dopo la sfida agli LLM americani, DeepSeek alza la posta con il modello per generare immagini Janus Pro

A pochi giorni dal debutto del LLM R1 che ha scosso la Silicon Valley, DeepSeek torna alla ribalta con Janus Pro 1B e 7B, una famiglia di modelli multimodali progettati per generare immagini e gestire compiti di visione. Annunciati ieri su Hugging Face, questi modelli promettono di competere con DALL-E 3 di OpenAI.

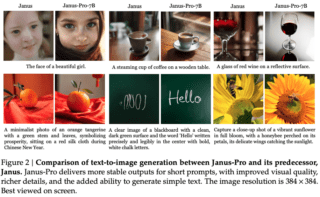

I Janus Pro migliorano il precedente modello Janus 1.3B decodificando il contenuto visivo su un percorso separato, mantenendo però un’unica architettura transformer per l’elaborazione. In un approfondimento tecnico, DeepSeek ha sottolineato che il modello originale soffriva di prestazioni subottimali per prompt brevi e immagini di qualità instabile, mentre con l’introduzione di dataset più ampi e parametri maggiori molti di questi limiti sembrano superati.

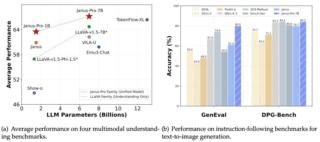

Secondo DeepSeek, il modello Janus Pro 7B supera di poco sia Stable Diffusion 3 Medium, sia DALL-E 3 nei benchmark GenEval e DPG-Bench. Tuttavia, al momento l’analisi delle immagini è limitata a una risoluzione di 384×384 pixel e ciò riduce la qualità nei dettagli più fini e in compiti come il riconoscimento ottico dei caratteri (OCR).

Come per il modello DeepSeek V3, i risultati sono stati ottenuti utilizzando un’infrastruttura relativamente contenuta, composta in questo caso da poche centinaia di GPU basate su PyTorch e il framework HAI-LLM. L’intero processo di addestramento ha inoltre richiesto tra 7 e 14 giorni, sfruttando cluster di 16-32 nodi con otto GPU Nvidia A100 per nodo. Inoltre, DeepSeek ha riutilizzato modelli precedenti, riducendo i tempi di sviluppo.

Il codice di Janus Pro è disponibile con licenza MIT, mentre i modelli Pro sono soggetti a una licenza specifica. Per chi fosse interessato, DeepSeek offre script per test locali su GitHub e una demo su Hugging Face Spaces, sebbene il caricamento possa risultare lento.