Ecco il gregge di Llama 4, due LLM multimodali e MoE distillati da un “insegnante modello”

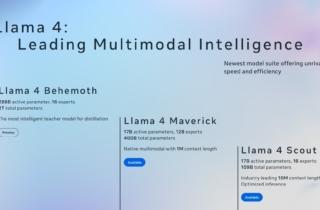

Meta ha annunciato l’arrivo della nuova suite di LLM Llama 4, segnando una svolta decisiva per il suo ecosistema di intelligenza artificiale open source. I nuovi modelli Llama 4 Scout e Llama 4 Maverick sono i primi della serie a integrare un’architettura Mixture of Experts (MoE) e a supportare nativamente input multimodali (testo e immagini), con prestazioni di alto livello in termini di efficienza, intelligenza e capacità di contesto. Inoltre, Meta ha svelato in anteprima Llama 4 Behemoth, un modello da quasi due trilioni di parametri pensato come “insegnante” per l’addestramento dei modelli più piccoli.

Due modelli principali già disponibili

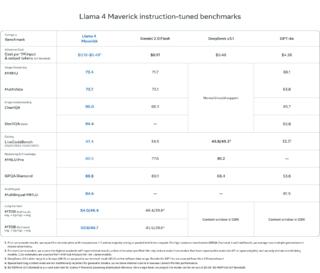

Llama 4 Scout e Llama 4 Maverick sono ora scaricabili da llama.com e da Hugging Face. Scout è un modello da 17 miliardi di parametri attivi con 16 esperti (sottomodelli specializzati) progettato per girare su una singola GPU NVIDIA H100 grazie alla quantizzazione Int4. Maverick, invece, ha la stessa dimensione attiva ma sfrutta ben 128 esperti per un totale di 400 miliardi di parametri. Anche questo LLM può funzionare su un singolo host H100, ma si presta meglio a sistemi distribuiti. Entrambi offrono elevate capacità multimodali e supportano lunghezze di contesto estese (fino a 10 milioni di token per Scout).

Come già accennato, i modelli Llama 4 sono i primi dell’ecosistema Meta a utilizzare un’architettura Mixture of Experts (MoE), nella quale solo una parte dei parametri viene attivata per ogni token, migliorando l’efficienza computazionale senza compromettere la qualità. Per esempio, Llama 4 Maverick impiega una combinazione di layer densi e MoE, con ciascun token instradato verso un esperto condiviso e uno dei 128 esperti dedicati.

Grazie alla progettazione multimodale con early fusion, questi modelli possono elaborare simultaneamente testo e immagini, fondendoli sin dall’inizio del processo. L’encoder visivo è stato aggiornato a partire da MetaCLIP, adattandolo in modo ottimale all’interazione con il LLM.

Innovazioni nel pre-training

L’addestramento dei modelli ha incluso oltre 30 trilioni di token combinando testo, immagini e video con una copertura linguistica estesa a 200 idiomi. L’uso della precisione FP8 (formato numerico pensato per accelerare l’addestramento e l’inferenza dei modelli) ha inoltre garantito un’efficienza elevata senza perdite qualitative e, per gestire i numerosi parametri, Meta ha introdotto una nuova tecnica di ottimizzazione degli iperparametri chiamata MetaP, che consente una maggiore flessibilità rispetto alle dimensioni del modello, profondità e batch size.

Scout, in particolare, è stato progettato per generalizzare su contesti lunghissimi grazie alla nuova architettura iRoPE (Interleaved Rotary Position Embeddings), che rimuove del tutto le embedding posizionali classiche in favore di un’attenzione intercalata e scalata dinamicamente.

Un modello “maestro”: Llama 4 Behemoth

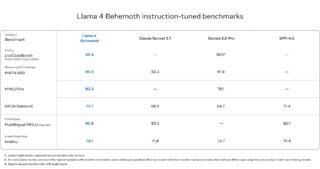

In parallelo, Meta ha sviluppato Llama 4 Behemoth, un colosso da 288 miliardi di parametri attivi e quasi due trilioni totali. Anche Behemoth è un modello multimodale con architettura MoE e ha già dimostrato prestazioni superiori a GPT-4.5, Claude 3.7 e Gemini 2.0 Pro in benchmark STEM (come MATH-500 e GPQA Diamond).

Behemoth non è ancora disponibile, ma è stato usato come “insegnante” nel processo di codistillazione di Maverick, contribuendo al salto di qualità dei modelli più piccoli. La strategia ha incluso una funzione di perdita innovativa che bilancia dinamicamente target soft e hard durante il training, mentre per il post-training Meta ha dovuto ripensare completamente le pipeline, filtrando fino al 95% dei dati SFT e impiegando un RL online asincrono e continuo per migliorare ulteriormente le capacità logiche e di ragionamento del modello.

Ottimizzazione post-training e sicurezza

Per il fine-tuning post-training, Meta ha adottato un nuovo approccio composto da supervised fine-tuning leggero, reinforcement learning online, e direct preference optimization (DPO) anch’esso alleggerito. L’obiettivo è stato quello di bilanciare performance su testo, immagini, coding e ragionamento, senza che una competenza penalizzasse l’altra. È stata fondamentale anche la selezione di prompt difficili per spingere il modello a generalizzare meglio in contesti complessi.

Con questo annuncio, Meta ha inoltre ribadito l’impegno verso un’IA aperta e sicura. I modelli Llama 4 sono stati infatti sviluppati seguendo le linee guida di sicurezza delineate nella AI Protections Developer Guide, con mitigazioni applicate a ogni fase, dal pre-training fino al deployment. Queste includono filtri dati, controlli comportamentali e strategie contro usi avversi.

Per quanto riguarda i bias, Meta vuole che i nuovi modelli siano in grado di comprendere e articolare entrambi i lati di una questione controversa, rispondendo senza giudizi o favoritismi. Con Llama 4 ci sono stati significativi miglioramenti rispetto a Llama 3:

- Il tasso di rifiuto nel rispondere a temi politici e sociali dibattuti è sceso dal 7% (Llama 3.3) a meno del 2%

- Le risposte rifiutate in modo sbilanciato sono scese a meno dell’1%

- La tendenza a rispondere con inclinazioni politiche marcate è pari a quella di Grok ed è dimezzata rispetto a Llama 3.3

Il futuro dell’ecosistema Llama

Scout e Maverick sono pensati per essere adottati sia da sviluppatori indipendenti, sia da aziende, offrendo un’alternativa accessibile alle soluzioni proprietarie. Con l’annuncio di Llama 4 Behemoth e l’imminente evento LlamaCon del 29 aprile, Meta intende infine rafforzare la community open source e accelerare l’innovazione nell’IA multimodale.