Dynatrace OpenPipeline: i dati al servizio di analytics, IA e automazione

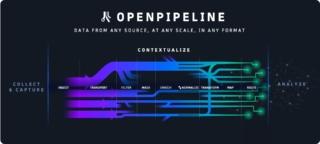

Dynatrace ha annunciato OpenPipeline, una nuova tecnologia core che fornisce ai clienti un’unica pipeline per gestire l’acquisizione di dati su scala petabyte nella piattaforma Dynatrace per alimentare analisi, intelligenza artificiale e automazioni sicure e convenienti.

Dynatrace OpenPipeline offre ai team di sviluppo, di sicurezza e operation piena visibilità e controllo dei dati che stanno inserendo nella piattaforma Dynatrace, preservando il contesto dei dati e gli ecosistemi cloud da cui hanno origine. Inoltre, valuta i flussi di dati da cinque a dieci volte più velocemente rispetto alle tecnologie legacy. In questo modo le aziende possono gestire meglio il volume sempre crescente e la varietà di dati provenienti dai loro ambienti ibridi e multicloud e consentire a più team di accedere alle risposte e alle automazioni basate sull’intelligenza artificiale della piattaforma Dynatrace senza bisogno di strumenti aggiuntivi.

Creare una pipeline unificata per gestire questi dati è impegnativo a causa della complessità delle moderne architetture cloud. La complessità e la proliferazione di strumenti di monitoraggio e analisi all’interno delle aziende possono inoltre mettere a dura prova i budget. Allo stesso tempo, le aziende devono conformarsi agli standard di sicurezza e privacy, come GDPR e HIPAA, in relazione alle pipeline di dati, all’analisi e alle automazioni e, di conseguenza, necessitano di visibilità e controllo chiari sulle informazioni, dovendo gestire contemporaneamente i costi e massimizzando il valore delle soluzioni di analisi e automazione dei dati esistenti.

Dynatrace OpenPipeline funziona con altre principali tecnologie della piattaforma di Dynatrace come Grail Data Lakehouse, topologia Smartscape e Davis Hypermodal AI e offre i seguenti vantaggi:

- Analisi dei dati su scala petabyte: sfrutta algoritmi di elaborazione dei flussi in attesa di brevetto per ottenere un throughput di dati significativamente maggiore su scala petabyte.

- Data ingestion unificata: consente ai team di acquisire e gestire dati di osservabilità, sicurezza ed eventi aziendali, inclusa Quality of Service (QoS) dedicata per eventi aziendali, da qualsiasi fonte e in qualsiasi formato, come Dynatrace OneAgent, API Dynatrace e OpenTelemetry, con tempi di conservazione personalizzabili per casi d’uso individuali.

- Analisi dei dati in tempo reale in fase di acquisizione: consente ai team di convertire dati non strutturati in formati strutturati e utilizzabili al momento dell’acquisizione, ad esempio trasformando i dati grezzi in serie temporali o dati di metrica e creando eventi aziendali dalle linee di log.

- Contesto dei dati completo: arricchisce e conserva il contesto di punti dati eterogenei, inclusi parametri, trace, log, comportamento degli utenti, eventi aziendali, vulnerabilità, minacce, eventi del ciclo di vita e molti altri, riflettendo le diverse parti dell’ecosistema cloud da cui hanno avuto origine.

- Controlli per la privacy e la sicurezza dei dati: offre agli utenti il controllo su quali dati analizzare, archiviare o escludere dall’analisi e include controlli di sicurezza e privacy completamente personalizzabili, come il mascheramento dei dati personali automatico e basato sui ruoli, per aiutare a soddisfare le esigenze specifiche dei clienti e requisiti normativi.

- Gestione vantaggiosa dei dati: aiuta i team a evitare l’acquisizione di dati duplicati e riduce le esigenze di archiviazione trasformando i dati in formati utilizzabili, ad esempio da XML a JSON, e consentendo ai team di rimuovere campi non necessari senza perdere informazioni, contesto o flessibilità di analisi.

Dynatrace OpenPipeline sarà disponibile per tutti i clienti di Dynatrace SaaS entro 90 giorni da questo annuncio, a partire dal supporto per log, metriche ed eventi aziendali. Seguirà poi il supporto per tipi di dati aggiuntivi.