Il data center entra nell’era dei rack da centinaia di kW: le sfide e le opportunità viste da Vertiv

Il tipo di infrastruttura necessaria a erogare la potenza di calcolo richiesta dall’intelligenza artificiale sta ponendo a chi crea e gestisce data center sfide inaudite. E non è solo un problema di consumi elevati ma anche di “densità” di quei consumi, che in termini di kilowatt sta ormai entrando nell’era delle tre cifre per ogni singolo armadio. Questo rende necessario ripensare tutta la catena di distribuzione elettrica, il raffreddamento che diventa obbligatoriamente a liquido, e gli UPS con le relative batterie.

È in questo contesto di mercato che Vertiv ha presentato la sua visione sulle tendenze dei data center per il 2025 e le sue più recenti soluzioni e partneship, nel corso di un appuntamento con la stampa europea tenutosi presso il suo centro di Ricerca e Sviluppo alle porte di Bologna.

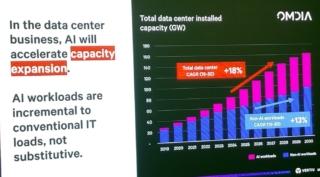

Trainata dalla domanda della IA, Vertiv sta ovviamente vivendo un momento molto positivo. “Le nostre azioni crescono come e più di quelle di Nvidia”, afferma Karsten Winther Presidente della regione , Europe, Middle East e Africa di Vertiv (nella foto di apertura), mentre mostra il grafico relativo a una ricerca Omdia che gli prospetta un futuro brillante: la capacità installata dei data center globali, attualmente 80 GW, raddoppierà nel 2030, trainata da una crescita media anno su anno del 18%, sotto la spinta combinata dei nuovi carichi di lavoro della IA e di quelli tradizionali, che cresceranno in ogni caso del 13% ogni anno.

Vertiv attende una crescita non solo negli enormi data center degli hyperscaler, ma anche nei data center degli stati e delle aziende, visto il crescente interesse nello sviluppo di soluzioni di intelligenza artificiale “sovrana”, per controllare attentamente la direzione dello sviluppo della IA e mantenere la governance dei dati.

La crescita dei data center è sostenibile?

Se da un lato la previsione di un raddoppio dei consumi energetici per alimentare le IA è vista come un’ottima prospettiva, nei giorni immediatamente successivi alla conferenza Cop 29 sul clima devono anche però rappresentare un segnale di preoccupazione.

“Sarà necessario porre attenzione all’efficienza energetica dei data center, anche cercando una collaborazione con tutti gli attori dell’industria per ottenere la migliore integrazione della IA”, afferma Winther. Il tema della sostenibilità coinvolge ovviamente anche la transizione delle fonti rinnovabili, che è sì benvenuta ma non priva di controindicazioni, prima tra tutte la variabilità nel livello di produzione. Le sezioni di alimentazione dei data center devono quindi adattarsi a questo nuovo scenario, combinando fonti diverse in base alla disponibilità del momento, e impiegando – accanto agli UPS che garantiscono un intervento rapido ma di breve durata – anche batterie di accumulo sul lungo periodo e altri sistemi di generazione green in grado di compensare una fornitura ridotta. E, qualora fosse necessario, possono anche anche in grado di supportare la rete elettrica, rifornendola di energia in caso di bisogno.

Un reference design per la IA in collaborazione con Nvidia

Winther ha sottolineato che per le tecnologie ad alta densità come la piattaforma Blackwell di Nvidia non ci sono ancora esperienze consolidate e reference design definiti, tanto per la creazione di nuovi data center, quanto per l’adattamento di data center esistenti.

“Ci sono pochi costruttori di sistemi di raffreddamento a liquido, e molti usano differenti approcci incompatibili tra loro, così come c’è molta variabilità nelle temperature di esercizio richieste dai diversi produttori di chip. Dobbiamo andare invece verso una maggiore standardizzazione e modularità delle tecnologie di raffreddamento” – dice Phillip Marangella, Chief Marketing e Product Officer di EdgeConneX, fornitore di servizi data center globale, nel corso di un panel dedicato ai clienti.

Per rispondere all’esigenza di standardizzazione e inserimento graduale di elementi ad alta densità di con raffreddamento a liquido in data center esistenti nati in un’altra epoca, Vertiv ha annunciato la creazione di un’architettura di riferimento per la piattaforma NVIDIA GB200 NVL72 e sviluppata in collaborazione con NVIDIA. La soluzione permetterà di trasformare i data center tradizionali in AI factories attraverso l’inserimento di rack preconfigurati e corredati dei sistemi di supporto e raffreddamento e liquido in grado di supportare fino a 132 kW ciascuno.

Chiamato in causa sul tema della sostenibilità della IA, il Vice President delle Enterprise Solutions and Operations di Nvidia Carlo Ruiz ha sottolineato che “se è vero che le GPU Nvidia consumano molto, bisogna considerare che l’energia per produrre un token è crollata di 45.000 volte in 8 anni, e che due GPU server possono sviluppare una potenza di calcolo che, con le sole CPU, richiederebbe 960 server”.

Un tempo bandita dai data center, ora l’acqua è dappertutto

Marangella solleva anche un altro potenziale problema – “fino a poco tempo fa, l’acqua era bandita dai data center, perché un pericolo per i server e i dati che custodiscono. Ora invece è dappertutto, e ho paura che gli addetti alle operazioni e manutenzione non sappiano ancora bene come gestirla”.

Flora Cavinato Senior Director Global Service Strategy and Portfolio di Vertiv

“La presenza di acqua negli impianti, fino a poco tempo fa vista come la peste nera, impone nuovi standard e livelli di servizio”, ci racconta Flora Cavinato, Senior Director Global Service Strategy and Portfolio di Vertiv. “Operare in un data center che impiega il liquid cooling significa lavorare con condizioni molto stringenti, per esempio sulla qualità del liquido, per non correre il rischio di danneggiare i componenti. Attraverso la linea Life Services (che saranno a breve ribattezzati Next Response, Vertiv è in grado di monitorare da remoto le effettive condizioni operative attraverso la raccolta di dati e intervenire rapidamente in modo proattivo con un troubleshooting remoto o programmando un intervento di manutenzione”.

I trend dei data center in Italia

Il mercato italiano dei data center sta vivendo una fase di profonda trasformazione e forte crescita. “Fino a pochi anni fa il nostro era un mercato di piccoli data center, da pochi megawatt ciascuno. Da due o tre anni, con l’arrivo dei grandi hyperscaler e colocator, stiamo vedendo una crescita che paesi come Irlanda, Francia, Germania e Olanda hanno vissuto qualche anno fa”, ci dice Andrea Faeti, Sales Enteprise Account Director di Vertiv.

Il fatto che arriviamo con un po’ di ritardo però non significa che l’Italia sia un mercato minore, anzi. Faeti ci conferma che per Vertiv il nostro paese occupa solidamente la seconda posizione in Europa in termini di fatturato. Cosa richiedono quindi i clienti italiani?

Andrea Faeti Sales Enterprise Account Director di Vertiv

Tra le medie aziende, Faeti vede “un progressivo spostamento dalle infrastrutture on-prem verso la colocation e il cloud, che possono offrire una maggiore efficienza perché per il gestore è un elemento strategico del business, ma anche su scala più piccola si cominciano a vedere iniziative che di solito erano appannaggio di quelle di classe Enterprise, per esempio per lo sviluppo di sistemi proprietari per gestire processi di inferenza dei modelli IA (la fase di interrogazione di un modello, che viene dopo quella del suo addestramento, NdR). Con queste aziende stiamo lavorando inserire in data center già esistenti piccole porzioni ad alta densità in modo graduale, anche sfruttando l’aria refrigerata per raffreddare il liquido che serve ai sistemi di ultima generazione”.

“Le aziende più grandi cercano assistenza nel realizzare soluzioni che attraversino tutte le aree, alimentazione, cooling e infrastruttura, mentre gli hyperscaler sono invece molto attenti all’aspetto tecnologico e si concentrano su tecnologie specifiche”, conclude.