Con la GPU Instinct MI325X AMD sfida il dominio di Nvidia. Arrivano anche gli EPYC Gen 5

In occasione dell’evento Advancing AI, AMD ha presentato le più recenti soluzioni di IA e calcolo ad alte prestazioni tra cui i processori EPYC Gen 5 e gli acceleratori IA Instinct MI325X, nonché ospitato clienti e partner di primo piano tra cui Microsoft, OpenAI, Meta, Oracle, Google Cloud e altri ancora.

Durante la presentazione, il presidente e CEO di AMD, Lisa Su, ha illustrato diverse novità che permetteranno di aumentare le capacità di calcolo, migliorare l’efficienza energetica e fornire ad aziende e utenti nuovi livelli di accesso all’intelligenza artificiale. Ecco gli annunci principali.

AMD EPYC Gen 5 serie 9005

I nuovi processori Epyc di quinta generazione, nome in codice Turin, sono disponibili in due varianti:

- Una versione ottimizzata per le prestazioni con 8-128 core Zen 5 completi

- Una versione ottimizzata per il throughput con 96-192 core Zen 5C compatti

AMD afferma che l’Epyc 9965 da 192 core offre prestazioni fino a 4 volte superiori in carichi di lavoro reali, mentre la versione con core Zen 5 completi vanta un aumento dell’IPC del 17% per le applicazioni server.

I nuovi processori, realizzati con il processo a 4nm di TSMC per i core Zen 5 e 3nm per i core Zen 5C, utilizzano fino a 16 chiplet CCD, aumentando il conteggio massimo dei core rispetto alla generazione precedente. Mantengono comunque la compatibilità con il socket SP5, ma i modelli da 500W richiedono nuove schede madri.

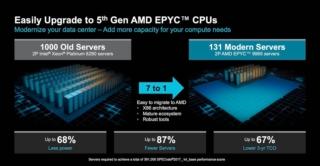

AMD punta sulla consolidazione dei server, affermando che un sistema dual-socket Turin può sostituire fino a 7 server Intel Cascade Lake obsoleti, con un risparmio energetico del 68%.

AMD stima inoltre di controllare attualmente il 33,7% del mercato CPU per data center in termini di fatturato e, con gli EPYC Gen 5, punta ad aumentare ulteriormente la sua quota di mercato, soprattutto sostituendo i vecchi sistemi Xeon Cascade Lake in fase di aggiornamento.

AMD Instinct MI325X

I nuovi acceleratori IA Instinct MI325X segnano secondo AMD un’importante evoluzione della serie MI300 introdotta lo scorso anno. Il miglioramento più significativo riguarda la memoria VRAM, che passa da 192 GB di HBM3 a 256 GB di HBM3e più veloce. Questa mossa rispecchia la strategia adottata da Nvidia con il suo H200, concentrandosi sull’aumento della capacità e della larghezza di banda della memoria.

L’Instinct MI325X vanta inoltre una larghezza di banda della memoria di 6 TB/s, in aumento rispetto ai 5,3 TB/s del modello precedente. Tuttavia, questo potenziamento ha comportato un aumento del TDP, che è salito a 1.000 watt (250 watt in più rispetto alla generazione precedente) e, nonostante l’incremento di potenza, le prestazioni in termini di precisione in virgola mobile rimangono simili, con 1,3 petaFLOPS in FP16 e 2,6 petaFLOPS in FP8.

AMD afferma che il MI325X supera le prestazioni del Nvidia H200 del 20-40% nell’inferenza con modelli Llama 3.1 70B e 405B. Nel training di Llama 2 70B, il vantaggio si riduce al 10% per un singolo acceleratore, mentre le prestazioni sono equivalenti a livello di sistema. La disponibilità dei MI325X è prevista per il quarto trimestre del 2024, con sistemi completi da vari produttori attesi nel primo trimestre del 2025.

Guardando al futuro, AMD ha anticipato il MI355X, basato sulla nuova architettura CDNA 4 e previsto per la seconda metà del 2025. Questo modello promette 288 GB di memoria HBM3e e prestazioni fino a 9,2 petaFLOPS utilizzando i nuovi tipi di dati FP4 o FP6. Si prevede un aumento dell’80% nelle prestazioni per FP/BF16 e FP8, posizionando AMD in diretta concorrenza con i futuri acceleratori IA B200 di Nvidia.