Data leak e LLM usati per attacchi DDoS: i tanti problemi di sicurezza della IA

Un team di esperti di Microsoft, dopo aver passato al setaccio più di 100 prodotti basati su IA generativa, è giunto a una conclusione che fa riflettere: i sistemi di IA non possono essere resi completamente sicuri. Anzi, l’IA non si limita ad amplificare i rischi di sicurezza esistenti, ma ne crea anche di nuovi.

Il problema, a quanto pare, è intrinseco: i modelli di IA, se alimentati con input non attendibili, possono produrre output imprevedibili e questo diventa un problema enorme quando l’input contiene informazioni sensibili. Per questo i ricercatori di ricercatori Microsoft sottolineano che la sicurezza dei sistemi di IA sarà una sfida continua, che richiederà un impegno costante per stare al passo con le nuove minacce.

I ricercatori suggeriscono inoltre un approccio multidimensionale alla sicurezza dell’IA basato su quattro principi:

- Comprensione profonda del sistema: è fondamentale capire come funziona un sistema di IA e in quali contesti viene applicato per poterlo proteggere efficacemente

- Red teaming automatizzato: l’uso di strumenti automatici per simulare attacchi e individuare vulnerabilità può essere molto utile, ma non deve sostituire completamente l’intervento umano

- Importanza del fattore umano: l’esperienza, la competenza e l’intelligenza emotiva degli esperti di sicurezza sono fondamentali per individuare e mitigare i rischi legati all’IA

- Misurazione dei danni: è importante sviluppare metodi per quantificare i danni causati da un uso improprio o dannoso dell’IA, anche quando questi danni sono difficili da definire

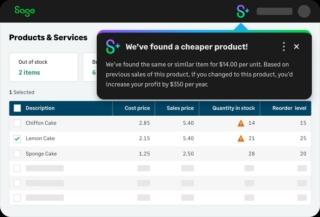

Un altro campanello di allarme emerso negli ultimi giorni sul rapporto tra IA e sicurezza riguarda Sage Copilot, un assistente virtuale pensato per semplificare la vita a chi usa gli strumenti contabili di Sage Group che ha mostrato ad alcuni clienti informazioni riservate che non avrebbero dovuto vedere.

Un utente, ad esempio, ha richiesto una lista di fatture recenti e si è visto recapitare dati provenienti da altri account, inclusi quelli di altri clienti. L’azienda ha minimizzato l’episodio, definendolo un “problema minore” e assicurando che è già stato risolto e che Sage Copilot ora funziona come previsto. La realtà però è che anche le aziende più attente alla sicurezza possono inciampare quando si tratta di IA, soprattutto per sistemi in fase di test come Sage Copilot, attualmente disponibile solo su invito.

Un terzo caso emblematico riguarda il crawler di ChatGPT, ovvero il sistema che raccoglie informazioni dai siti web citati dal chatbot. Questo crawler può essere ingannato per lanciare attacchi DDoS a causa del modo in cui gestisce le richieste HTTP POST all’endpoint API “attributions”; se si invia un elenco di URL che puntano allo stesso sito, ma scritti in modo leggermente diverso, il crawler cercherà di accedere a ognuno di essi simultaneamente, sovraccaricando il server.

La cosa preoccupante è che questo tipo di attacco, definito “DDoS riflessivo non autenticato”, è particolarmente difficile da contrastare, dal momento che la vittima si trova a dover bloccare il bot di ChatGPT che si presenta con diversi indirizzi IP, oscurando la vera fonte dell’attacco. La vulnerabilità del crawler di ChatGPT solleva interrogativi sulla sicurezza dei sistemi di IA in generale, soprattutto per quanto riguarda la loro capacità di gestire input potenzialmente dannosi.

Il ricercatore che ha scoperto la falla, Benjamin Flesch, ha criticato OpenAI per non aver implementato misure di sicurezza basilari, come la deduplicazione degli URL o la limitazione delle dimensioni degli elenchi di URL. Flesch ha anche sollevato preoccupazioni riguardo alla possibilità di “prompt injection” tramite l’endpoint “attributions”, una vulnerabilità che potrebbe consentire a malintenzionati di manipolare il comportamento del crawler.