Apple Ferret: arriva l’IA multimodale di Cupertino

Apple Ferret è un nuovo modello di intelligenza artificiale multimodale in grado di comprendere le immagini attraverso un ragionamento congiunto su input visivi e testuali

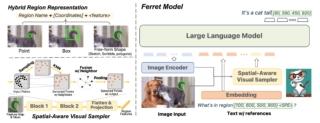

Apple ha reso open-source un nuovo modello di intelligenza artificiale generativa multimodale chiamato Ferret. Sviluppato congiuntamente da ricercatori di Apple e della Cornell University, Ferret è approdato su GitHub nell’ottobre 2023 e combina la visione artificiale e l’elaborazione del linguaggio naturale per adottare un approccio innovativo all’interazione con i contenuti visivi. È in grado di identificare oggetti e regioni all’interno di un’immagine, di associare i concetti testuali agli elementi visivi e di sfruttare questa comprensione per avere conversazioni testuali ricche di sfumature sulle immagini.

L’innovazione principale di Ferret è la capacità di rilevare oggetti e concetti semantici all’interno di regioni di un’immagine specificate dall’utente, invece di analizzare l’intera immagine. Ad esempio, un utente può disegnare una forma irregolare intorno al volto di una persona in una foto e chiedere “Di che colore sono gli occhi di questa persona?”. Ferret identifica gli occhi all’interno di quella regione, rileva che sono blu e risponde: “Questa persona ha gli occhi blu”.

Ferret va però oltre il riconoscimento di base degli oggetti. È in grado di comprendere le relazioni tra gli oggetti, le azioni e altri dettagli contestuali per avere una ricca conversazione a più voci su un’immagine. Questo lo rende più capace di chattare in base alla regione rispetto ai precedenti sistemi di intelligenza artificiale multimodale.

Per raggiungere questo obiettivo, Ferret utilizza un’architettura a doppio encoder. Un decoder si concentra sugli aspetti visivi, mentre l’altro gestisce l’input testuale. I due flussi di dati vengono fusi utilizzando un nuovo meccanismo di fusione dinamica e ciò consente un uso equilibrato di entrambe le modalità durante l’addestramento.

Per ottimizzare le capacità di riferimento visivo e di messa a terra di Ferret, i ricercatori hanno curato con attenzione un set di dati su larga scala chiamato GRIT (Ground-and-Refer Instruction Tuning), che contiene oltre 1,1 milioni di campioni diversi con una ricca conoscenza spaziale a più livelli: oggetti, relazioni, descrizioni di regioni e ragionamenti.

Ferret ha fin qui superato in modo significativo i precedenti LLM multimodali nei compiti che richiedevano la comprensione e la localizzazione su base regionale durante le conversazioni. Secondo i ricercatori, le valutazioni quantitative e qualitative hanno dimostrato che le capacità di Ferret vanno oltre i modelli esistenti. Il modello ha infatti dimostrato di aver migliorato le capacità di descrizione delle immagini a grana fine e di aver ridotto i problemi di allucinazione presenti in altri LLM.

Ferret, come già detto, è concesso in licenza open-source non commerciale (scelta piuttosto atipica per Apple) e questo modello distributivo comporta tre vantaggi chiave:

- Collaborazione: I ricercatori di tutto il mondo possono costruire sulle fondamenta di Ferret e Apple beneficia di questo progresso collettivo.

- Innovazione: Con il codice disponibile pubblicamente, possono emergere nuove estensioni e applicazioni di Ferret al di là di quanto previsto da Apple.

- Trasparenza: L’open-sourcing dissipa i timori di parzialità e sicurezza che circondano i sistemi di intelligenza artificiale proprietari e chiusi.

Alcuni sviluppi futuri per Ferret includono l’estensione ad altre modalità oltre alle immagini e al testo, il potenziamento del ragionamento basato sul buon senso e il miglioramento delle basi fattuali. Dal punto di vista applicativo, Ferret potrebbe inoltre essere incorporato in prodotti Apple come Spotlight per comprendere le richieste degli utenti sulle immagini.