Con Llama 3.1, Meta rilancia la sfida a OpenAI e Anthropic

Meta ha annunciato il rilascio di Llama 3.1 405B, definito come il più grande e capace LLM open source attualmente disponibile. Questa novità rappresenta un importante passo avanti nel campo dell’intelligenza artificiale open source, che finora era generalmente considerata meno avanzata rispetto ai modelli chiusi.

Llama 3.1 405B si propone di competere con i migliori modelli IA in termini di conoscenza generale, adattabilità, matematica, uso di strumenti e traduzione multilingue. Meta prevede che questo modello stimolerà nuove applicazioni e paradigmi, inclusa la generazione di dati sintetici e la distillazione di modelli su larga scala.

Oltre al modello da 405 miliardi di parametri, Meta ha anche rilasciato versioni aggiornate dei modelli più piccoli 8B e 70B, che offrono funzionalità multilingue, una lunghezza di contesto estesa a 128K token e migliori capacità di ragionamento. Tutti i modelli sono disponibili per il download e lo sviluppo su varie piattaforme partner.

Meta ha condotto valutazioni approfondite su oltre 150 dataset di riferimento in diverse lingue, oltre a valutazioni umane in scenari reali. I risultati suggeriscono che il modello da 405B è competitivo con modelli leader come GPT-4, GPT-4o e Claude 3.5 Sonnet. Anche i modelli più piccoli si dimostrano competitivi con modelli chiusi e aperti di dimensioni simili.

L’addestramento di Llama 3.1 405B ha richiesto oltre 15 trilioni di token e l’utilizzo di più di 16.000 GPU H100 di Nvidia. Per gestire questa scala, Meta ha optato per un’architettura transformer decoder-only con adattamenti minori, evitando un approccio mixture-of-experts per massimizzare la stabilità dell’addestramento. È stata adottata una procedura iterativa post-addestramento che combina fine-tuning supervisionato e ottimizzazione diretta delle preferenze.

Meta ha migliorato sia la quantità, sia la qualità dei dati utilizzati per il pre-addestramento e il post-addestramento, sviluppando pipeline di pre-elaborazione più accurate e approcci di assicurazione della qualità più rigorosi. Il modello da 405B è stato anche utilizzato per migliorare la qualità post-addestramento dei modelli più piccoli.

Per supportare l’inferenza su larga scala, i modelli sono stati quantizzati da 16 bit (BF16) a 8 bit (FP8), riducendo i requisiti di calcolo e consentendo l’esecuzione su un singolo nodo server. Il fine-tuning per istruzioni e chat si è concentrato sul miglioramento dell’utilità, della qualità e della capacità di seguire istruzioni dettagliate, mantenendo al contempo elevati livelli di sicurezza. Il processo ha coinvolto più cicli di allineamento, ciascuno comprendente Supervised Fine-Tuning (SFT), Rejection Sampling (RS) e Direct Preference Optimization (DPO). La generazione di dati sintetici è stata ampiamente utilizzata per produrre esempi di SFT di alta qualità.

Meta ha inoltre introdotto il concetto di “Llama System”, una visione che va oltre i modelli di base per offrire agli sviluppatori un sistema più ampio e flessibile. Questa visione include componenti esterni come Llama Guard 3 (un modello di sicurezza multilingue) e Prompt Guard (un filtro per le iniezioni di prompt). L’approccio open source di Llama permette agli sviluppatori di personalizzare completamente i modelli per le loro esigenze, addestrarli su nuovi dataset e condurre ulteriori fine-tuning. Questo approccio mira a democratizzare l’accesso all’IA generativa e a promuovere l’innovazione su scala globale.

Meta riconosce che lavorare con un modello delle dimensioni di 405B può essere impegnativo per lo sviluppatore medio. Per questo motivo, ha collaborato con partner dell’ecosistema come AWS, NVIDIA e Databricks per offrire soluzioni che facilitino l’utilizzo del modello, inclusi inferenza in tempo reale e batch, fine-tuning supervisionato, valutazione, pre-addestramento continuo, Retrieval-Augmented Generation (RAG), chiamate di funzioni e generazione di dati sintetici.

Prima del rilascio di Llama 3.1 405B, Meta ha condotto esercizi di scoperta dei rischi pre-deployment attraverso il red teaming e il fine-tuning per la sicurezza, coinvolgendo esperti sia esterni che interni per testare i modelli e identificare potenziali usi imprevisti.

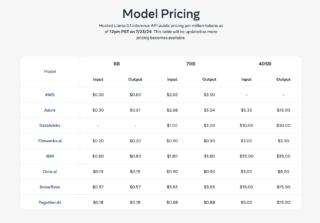

Llama 3.1 405B è disponibile da diversi partner in modalità as-a-service e con costi al milione di token, come si può vedere nell’immagine sottostante:

Il modello as-a-service offre diversi benefici, tra cui

- Accessibilità: Permette anche a sviluppatori con risorse limitate di utilizzare un modello di grandi dimensioni come il 405B

- Scalabilità: I servizi cloud possono facilmente scalare in base alle esigenze, senza richiedere investimenti in hardware costoso

- Facilità d’uso: Molte delle complessità tecniche sono gestite dai fornitori di servizi, permettendo agli sviluppatori di concentrarsi sull’applicazione piuttosto che sull’infrastruttura

- Flessibilità: Gli sviluppatori possono scegliere tra diversi fornitori e servizi in base alle loro esigenze specifiche

- Aggiornamenti continui: I fornitori di servizi possono mantenere aggiornati i modelli e l’infrastruttura, garantendo prestazioni ottimali

Llama 3.1 405B non sarà però disponibile (almeno per ora) nell’Unione Europea. Meta ha infatti citato la “natura imprevedibile” delle normative europee su IA, concorrenza a privacy come motivo principale di questa decisione. Ciò significa che le aziende e i ricercatori europei non avranno accesso diretto a uno dei modelli linguistici più potenti disponibili, ponendoli potenzialmente in una posizione di svantaggio nella corsa globale all’intelligenza artificiale.