GPT-4o Mini manderà in pensione GPT 3.5 nella versione gratuita di ChatGPT

OpenAI ha introdotto GPT-4o Mini, una versione ridotta e più economica del suo modello linguistico avanzato GPT-4o. Questa variante compatta, che può generare fino a 16.000 token di output e che sostituirà GPT 3.5 nella versione gratuita di ChatGPT, condivide alcune caratteristiche con il modello principale, come la capacità multimodale e una finestra contestuale di 128.000 token, con dati di addestramento aggiornati fino a ottobre 2023.

Dal punto di vista economico, mentre GPT-4o standard ha un costo di 5 e 15 dollari per milione di token rispettivamente in input e output, la nuova versione Mini richiede solo 15 e 60 centesimi.

Attualmente, GPT-4o Mini supporta solo testo e visione attraverso la sua API, con la promessa di integrare altri formati come l’audio in futuro. OpenAI ha posto particolare enfasi sulla sicurezza del modello, affermando di aver filtrato contenuti offensivi dai dati di addestramento e di aver implementato le stesse misure di protezione presenti in GPT-4o.

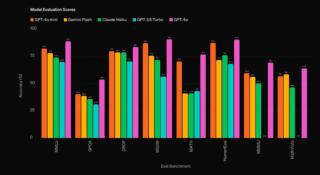

GPT-4o Mini supererebbe LLM comparabili in diversi benchmark. Confrontato con Gemini Flash di Google e Claude Haiku di Anthropic, Mini ha mostrato un’accuratezza superiore del 5-15% in test come MMLU, con però alcune prestazioni in cui ha quasi raddoppiato l’accuratezza dei concorrenti. Tuttavia, in un caso specifico, si è rivelato leggermente meno preciso di Gemini Flash, pur mantenendosi davanti a Claude Haiku.

Nonostante i risultati positivi nei benchmark, GPT-4o Mini non mostra un vantaggio schiacciante, riflettendo la recente perdita di leadership assoluta di OpenAI nel campo dei modelli linguistici di grandi dimensioni. I migliori modelli attualmente disponibili (GPT-4o, Claude 3.5 Sonnet e Gemini 1.5 Pro) sono infatti vicinissimi tra loro in termini di prestazioni.

Nel benchmark LMSYS Chatbot Arena, che offre una valutazione più realistica della qualità dei modelli linguistici, GPT-4o (non Mini) mantiene solo un leggero vantaggio sui suoi rivali. Claude 3.5 Sonnet di Anthropic e Gemini 1.5 Pro di Google seguono infatti molto da vicino, con punteggi rispettivamente di 1.271 e 1.267 punti contro i 1.287 di GPT-4o.