Da HPE e Nvidia, una soluzione AI-native per il fine tuning e l’inferenza on-prem

In apertura del suo evento annuale HPE Discover in corso a Barcellona, HPE ha annunciato in partnership con Nvidia una nuova linea di soluzioni ottimizzate per l’intelligenza artificiale generativa e che ha definito “AI-native”, in contrapposizione alle soluzioni pensate per il cloud che hanno caratterizzato le infrastrutture IT negli ultimi due decenni. Se nel cloud un nodo poteva gestire diverse applicazioni, la IA richiede invece che un singolo workload venga distribuito su migliaia di nodi, in modo analogo a quanto accade nei supercomputer.

Non sorprende quindi il trovare nella gamma, accanto ai server HPE ProLiant, anche i supercomputer della serie Cray, entrambi potenziati con GPU e interconnessioni ad alte prestazioni Nvidia ottimizzate per training, fine tuning e inferenza dei modelli di intelligenza artificiale generativa.

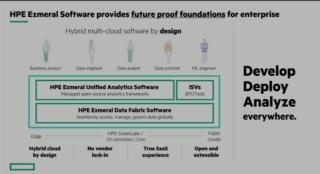

L’offerta AI-native non si limita però all’hardware, ma comprende anche l’ambiente di sviluppo HPE Machine Learning Development Environment, la piattaforma di data lakehouse per applicazioni analytics containerizzate e ottimizzato per il calcolo GPU HPE Ezmeral Software in cui raccogliere e preparare i dati di training e, infine, la suite di software NVIDIA AI Enterprise, compreso il framework NVIDIA NeMo.

Ora, a ben guardare, è difficile trovare un vendor hardware o cloud provider che negli ultimi mesi non abbia annunciato una partnership con Nvidia sull’intelligenza artificiale e gran parte dei software che compongono l’offerta è in realtà open source.

“In questo momento storico, non c’è azienda che non si stia interrogando sul come adottare la IA generativa prima che questa stravolga il suo settore” sostiene Neil McDonalds, Executive Vice President & General Manager della divisione Compute di HPE. “Questa soluzione pre-integrata e pacchettizzata che combina le tecnologie di HPE e Nvidia con stack software, pipeline per il trattamento dei dati e ambiente di sviluppo (con gli stessi strumenti che sviluppatori e data scientist sono abituati a usare) rappresenta il percorso più rapido per la transizione alla IA”.

Soluzioni per diversi tipi di workload IA

La maggior parte delle imprese non avrà bisogno di addestrare un proprio foundation model per la IA generativa, ma si limiterà a fare il fine-tuning di un modello esistente e a integrarlo con i dati aziendali proprietari per abilitare la modalità chiamata Retrieval Augmented Generative AI, cioè la IA generativa “potenziata” dall’accesso a dati certificati. Per questo tipo di compito, la proposta di HPE e Nvidia è costituita da un cluster su scala rack con 16 server HPE ProLiant Compute DL380a preconfigurati con 64 GPU NVIDIA L40S, DPU NVIDIA BlueField-3 e switch ad alte prestazioni NVIDIA Spectrum-X Ethernet Networking Platform.

Questa soluzione, che sarà disponibile dal primo trimestre 2024, è progettata per gestire i carichi di fine tuning e inferenza con il modello Llama-2 di Meta con 70 miliardi di parametri (al momento la punta di diamante tra i modelli open source), ma è certificata anche per modelli più piccoli come Mistral o Stable Diffusion, che “se adattati attraverso il fine-tuning, possono svolgere in modo efficace compiti specifici”, commenta Manuvir Das, VP della divisione Enteprise Computing di Nvidia.

Per istituzioni di ricerca, governi e grandi aziende che invece devono fare il vero e proprio addestramento di un proprio modello IA, HPE aveva presentato nelle scorse settimane la soluzione di supercomputing per IA “chiavi in mano” basata sul sistema exascale HPE Cray EX2500 con chip NVIDIA GH200 Grace Hopper, che può scalare fino a gestire migliaia di GPU.