IA generativa e marketing: un matrimonio sempre più florido

Secondo una nuova indagine di Gartner, il 63% dei responsabili marketing prevede di investire nell’IA generativa nei prossimi 24 mesi. Poco più della metà degli intervistati (56%) vede nell’IA generativa una ricompensa maggiore del rischio.

L’indagine CMO Spend and Strategy Survey 2023 è stata condotta nei mesi di maggio e giugno 2023 intervistando 405 leader del marketing, rivelando che l’utilizzo della capacità complessiva dello stack martech della loro organizzazione è sceso in media al 33% nel 2023, segnando il secondo anno consecutivo di declino (42% nel 2022 e 58% nel 2020).

“I CMO riconoscono sia le promesse, sia le sfide dell’IA generativa” ha dichiarato Benjamin Bloom, VP Analyst della divisione Marketing di Gartner. “C’è una chiara tensione tra investire di più nell’attuale stack tecnologico per incrementare l’utilizzo, o riallocare le risorse limitate verso la prossima generazione di applicazioni di IA generativa che potrebbero non soffrire degli stessi problemi di utilizzo”.

L’indagine ha anche rilevato che le organizzazioni stanno spendendo il 25,4% del loro budget di marketing per il 2023 in tecnologia. Con il forte calo dell’utilizzo delle tecnologie di marketing, la pressione per l’ottimizzazione dei costi sarà inevitabile, visto che gli addetti al marketing utilizzano solo un terzo delle funzionalità tecnologiche che consumano un quarto dell’intero budget. Al contrario, le poche organizzazioni che utilizzano più del 50% del loro stack martech hanno una probabilità significativamente inferiore di vedersi chiedere di tagliare il budget.

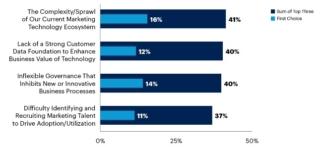

Aumentare l’utilizzo del martech da parte di un’organizzazione è difficile; solo l’11% degli intervistati ha infatti dichiarato di aver aumentato l’utilizzo delle tecnologie di marketing di oltre il 10% nel 2023, rispetto a 12 mesi fa. La complessità dell’ecosistema attuale, le sfide legate ai dati dei clienti e la governance poco flessibile sono stati identificati dagli intervistati come gli impedimenti più comuni a un maggiore utilizzo del loro stack martech.

“I marketer tendono ad acquisire nuove tecnologie senza un approccio sistematico per adottarle“, continua Bloom. “In combinazione con i contratti pluriennali, una tecnologia sottoutilizzata o abbandonata può facilmente portare a un accumulo ingombrante nel tempo. I CMO dovrebbero spingere i team martech a trovare opportunità di semplificazione per consentire al resto della funzione di prosperare. Tagliare le tecnologie sottoutilizzate all’interno dello stack attuale può anche preservare un po’ di risorse per applicazioni trasformative che non sono ancora generalmente disponibili”.