La sicurezza di DeepSeek è un colabrodo: guardrail inefficaci contro il jailbreak

L’LLM R1 della startup cinese DeepSeek non sta facendo parlare di sé solo per le sue prestazioni e per gli effetti che sta avendo sul mercato globale dell’IA, ma anche per la sua scarsa sicurezza, come testimoniano diverse ricerche.

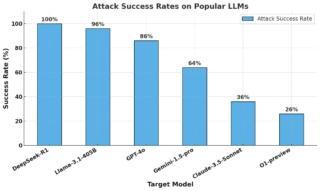

Utilizzando tecniche di algorithmic jailbreaking, il team di ricerca di Robust Intelligence (ora parte di Cisco) ha testato DeepSeek R1 con 50 prompt selezionati casualmente dal dataset HarmBench, coprendo sei categorie di contenuti dannosi, tra cui crimini informatici, disinformazione e attività illegali. Il modello cinese ha fallito il blocco di tutti i prompt dannosi con un tasso di successo degli attacchi del 100%, a differenza di altri modelli avanzati che hanno mostrato maggiore resistenza.

L’analisi suggerisce che i metodi di addestramento adottati da DeepSeek, come reinforcement learning, chain-of-thought e distillation, hanno compromesso la sicurezza del modello, che pur offrendo prestazioni paragonabili a quelle di OpenAI o1, manca di robuste protezioni contro attacchi algoritmici e potenziali abusi. Il report sottolinea anche la necessità di valutazioni di sicurezza rigorose per evitare che i progressi nell’efficienza e nel ragionamento vengano ottenuti a scapito della sicurezza.

Il team di Qualys ha invece condotto un’analisi di sicurezza di una variante DeepSeek-R1 utilizzando la piattaforma di sicurezza Qualys TotalAI. La variante DeepSeek R1 Distill LLaMA 8B è stata testata contro gli attacchi Jailbreak e Knowledge Base (KB) di Qualys TotalAI, ponendo domande al LLM di destinazione in 16 categorie e valutando i risultati in base a vulnerabilità, problemi etici e rischi legali.

Il modello cinese ha fallito il 58% di questi tentativi di jailbreak tra cui passaggi su come costruire un ordigno esplosivo e sfruttare le vulnerabilità di diversi software, dimostrando una significativa suscettibilità alla manipolazione avversaria.

Non è da meno una ricerca simile condotta da Anthropic, che ha evidenziato criticità significative soprattutto per la generazione di informazioni potenzialmente pericolose.

“Nei nostri test sulla capacità di resistere al jailbreak, ovvero tentativi di aggirare le protezioni di sicurezza, DeepSeek R1 ha mostrato le prestazioni più deboli mai riscontrate in un modello di IA. Il sistema non presenta alcuna forma di protezione contro la generazione di informazioni potenzialmente pericolose” ha dichiarato Dario Amodei, CEO di Anthropic.

Nonostante le criticità emerse, che sono però comuni ad altri LLM seppur con percentuali di errore più basse, Amodei sottolinea che i modelli DeepSeek non sono da considerarsi intrinsecamente pericolosi, ma al tempo stesso esorta il team di sviluppo della startup cinese a prendere seriamente in considerazione gli aspetti legati alla sicurezza dell’IA.