La tedesca Aleph Alpha e AMD lavorano a una soluzione per la IA sovrana e che parla lingue locali

La tedesca Aleph Alpha, tra le prime startup europee in campo IA, ha annunciato, in partnership con AMD, un’innovazione nell’architettura degli LLM, che spesso, siano essi open-source o proprietari, incontrano difficoltà nell’apprendere nuove lingue o conoscenze specifiche di settore, essenziali per aziende e governi.

Questo avviene perché tali modelli basano i loro schemi di apprendimento su versioni tokenizzate dei dati di addestramento originali, rendendo inefficace il fine-tuning su testi molto diversi. L’architettura senza tokenizer di Aleph Alpha punta proprio a superare questi limiti, rendendo possibile il training e l’ottimizzazione dei modelli su alfabeti diversi, lingue con risorse limitate e conoscenze di nicchia.

Questa innovazione è destinata a gettare le basi per una nuova generazione di soluzioni di IA sovrane che consentiranno ai governi e alle imprese di costruire le proprie soluzioni di IA sovrane basate sulla propria lingua madre, sulle specifiche culturali e sulle conoscenze e terminologie specializzate. Le conseguenze, secondo Aleph Alpha, saranno la democratizzazione dell’accesso a questa tecnologia e la promozione della pluralità economica e culturale.

“La nostra architettura senza tokenizer risolve una sfida chiave nell’IA: creare modelli sovrani per lingue poco rappresentate e settori specifici. Con la tecnologia IA di AMD, apriamo nuove opportunità strategiche per governi e aziende” ha dichiarato Jonas Andrulis, fondatore e CEO di Aleph Alpha.

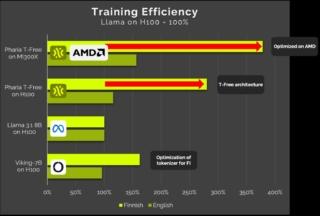

La nuova architettura sfrutta le capacità degli acceleratori AMD Instinct MI300 Series e del software open AMD ROCm, riducendo significativamente costi e impatto ambientale. Per esempio, nel caso della lingua finlandese, si è ottenuta una riduzione del 70% dei costi di training e delle emissioni rispetto ai modelli tradizionali.

Aleph Alpha integra inoltre il nuovo modello con il sistema operativo Pharia ottimizzato su piattaforme AMD, in un approccio unisce software e hardware, migliora costi e impronta ecologica e introduce trasparenza ed efficienza senza nell’IA generativa.