OpenAI lancia il costosissimo LLM 01-pro e nuovi modelli di speech-to-text e text-to-speech

Negli ultimi mesi, OpenAI ha lanciato soluzioni come Operator, Deep Research, Computer-Using Agents e la Responses API con strumenti integrati, ma per rendere gli agenti AI davvero utili è fondamentale garantire un’interazione più profonda e intuitiva, permettendo la comunicazione attraverso il linguaggio parlato in modo naturale.

In tale ottica, l’azienda ha annunciato nuovi modelli audio di conversione da voce a testo (speech-to-text) e da testo a voce (text-to-speech) tramite API, permettendo lo sviluppo di agenti vocali più potenti, personalizzabili e intelligenti. Secondo OpenAI, i nuovi modelli di speech-to-text stabiliscono un nuovo standard di riferimento, superando le soluzioni esistenti in termini di accuratezza e affidabilità, soprattutto in scenari complessi con accenti diversi, ambienti rumorosi e velocità di parlato variabili. Questi miglioramenti aumentano l’affidabilità della trascrizione, rendendo i modelli ideali per applicazioni come call center e trascrizione di riunioni.

Per la prima volta, gli sviluppatori possono istruire il modello text-to-speech su come parlare offrendo un nuovo livello di personalizzazione. Questo consente applicazioni su misura, come assistenti vocali più espressivi nel servizio clienti o narrazioni più coinvolgenti per esperienze di storytelling.

Nuovi modelli speech-to-text

“Abbiamo introdotto i modelli gpt-4o-transcribe e gpt-4o-mini-transcribe, che migliorano il tasso di errore delle parole (Word Error Rate – WER) e la capacità di riconoscimento delle lingue rispetto ai precedenti modelli Whisper”, si legge nel blog di OpenAI.

Il modello gpt-4o-transcribe dimostra miglioramenti significativi nella WER rispetto ai modelli Whisper v2 e v3, grazie a innovazioni mirate nel reinforcement learning e a un addestramento su dataset audio diversificati e di alta qualità. Di conseguenza, questi nuovi modelli catturano meglio le sfumature del parlato, riducono errori di riconoscimento e migliorano l’affidabilità della trascrizione, soprattutto in contesti complessi.

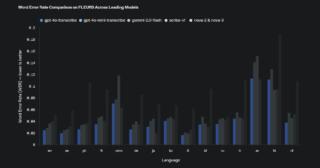

I modelli sono disponibili nella speech-to-text API e supportano numerose lingue, tra cui inglese, italiano, spagnolo, francese, cinese, tedesco, giapponese, coreano, russo, turco, arabo e molte altre. I test sui benchmark FLEURS dimostrano che questi modelli superano in accuratezza quelli concorrenti, garantendo un’ampia copertura linguistica e prestazioni robuste.

Su FLEURS, i nuovi modelli di OpenAI offrono un WER inferiore ed elevate prestazioni multilingue. Un WER più basso è migliore e significa meno errori. Come mostrato qui, i modelli eguagliano o superano altri modelli leader nella maggior parte delle lingue principali.

Nuovo modello text-to-speech

Il modello gpt-4o-mini-tts introduce una maggiore capacità di personalizzazione della voce ed è disponibile nella text-to-speech API. Da notare che le voci text-to-speech sono limitate a preset artificiali, monitorati per garantire che corrispondano a profili sintetici predefiniti.

Disponibilità dell’API

I nuovi modelli audio sono disponibili per tutti gli sviluppatori. L’integrazione con l’Agents SDK semplifica il processo di sviluppo per chi già utilizza modelli testuali, mentre per esperienze speech-to-speech a bassa latenza OpenAI consiglia di utilizzare i modelli nella Realtime API.

Arriva o1-pro… a caro prezzo

Il secondo annuncio di OpenAI riguarda il lancio dell’LLM di “ragionamento” o1-pro per gli sviluppatori tramite API; si tratta di una versione più potente di o1 che promette di offrire risposte ancora migliori grazie a una potenza di calcolo superiore. A caratterizzare o1 Pro è però anche il suo prezzo elevato, ovvero 150 dollari per milione di token di input e 600 dollari per milione di token di output, mentre con la Batch API, o1 Pro ha un prezzo di 75 dollari per milione di token di input e 300 dollari per milione di token di output.

Attualmente, o1-pro è accessibile a sviluppatori selezionati nei livelli 1-5, supporta anche vari strumenti per sviluppatori ed è compatibile con le API Responses e Batch appena annunciate.