Snowflake lancia Arctic, un LLM efficiente per il business ma open source

Snowflake ha annunciato Arctic, un large language model (LLM) progettato per essere il più aperto del mercato. Grazie all’architettura Mixture-of-Experts (MoE), Arctic è ottimizzato per i workload complessi e ha superato diversi benchmark di settore per quanto riguarda la generazione di codice SQL, l’esecuzione di istruzioni e altro ancora.

Secondo un recente report di Forrester, circa il 46% dei responsabili delle decisioni in materia di IA a livello aziendale ha dichiarato di sfruttare gli LLM open source esistenti per adottare la GenAI come parte della strategia della propria organizzazione. Snowflake, che costituisce la base dei dati per oltre 9.400 aziende e organizzazioni in tutto il mondo, consente a tutti gli utenti di sfruttare i propri dati con LLM aperti, offrendo loro flessibilità e possibilità di scelta dei modelli con cui lavorare.

Inoltre, fornisce modelli di codice, oltre a opzioni flessibili di inferenza e formazione, in modo che gli utenti possano iniziare rapidamente a distribuire e personalizzare Arctic utilizzando i loro framework preferiti. Questi includono NVIDIA NIM con NVIDIA TensorRT-LLM, vLLM e Hugging Face. Per l’utilizzo immediato, Arctic è disponibile per l’inferenza serverless in Snowflake Cortex, il servizio completamente gestito di Snowflake che offre soluzioni di machine learning e IA nel Data Cloud. Sarà anche disponibile su AWS, insieme ad altri modelli e cataloghi tra cui Hugging Face, Lamini, Microsoft Azure, NVIDIA API catalog, Perplexity, Together AI ed altri.

Il team di ricerca sull’IA di Snowflake ha impiegato meno di tre mesi e ha speso circa un ottavo del costo di formazione di modelli simili per la creazione di Arctic, che è stato addestrato utilizzando istanze P5 di Amazon Elastic Compute Cloud (Amazon ED2).

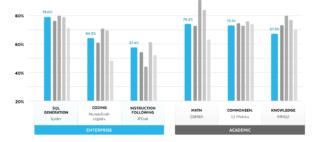

Nell’ambito di questo sforzo strategico, il design differenziato del MoE di Arctic migliora sia i sistemi di addestramento, sia le prestazioni del modello, con una composizione dei dati progettata e focalizzata sulle esigenze aziendali. Arctic offre anche risultati di qualità, attivando 17 dei 480 miliardi di parametri alla volta per ottenere un’elevata efficienza di token; attiva inoltre circa il 50% di parametri in meno rispetto a DBRX e il 75% in meno rispetto a Llama 3 70B durante l’inferenza o l’addestramento, oltre a superare i principali modelli aperti, tra cui DBRX, Mixtral-8x7B e altri ancora, nella codifica (HumanEval+, MBPP+) e nella generazione di SQL (Spider).

Oltre ad Arctic LLM, la famiglia di modelli Snowflake Arctic comprende Arctic embed, modelli di text embedding disponibili per la comunità open source con licenza Apache 2.0 ottimizzati per fornire prestazioni di retrieval a circa un terzo delle dimensioni di modelli analoghi, offrendo una soluzione versatile quando si combinano insiemi di dati proprietari con LLM come parte di un servizio RAG o di ricerca semantica.

Infine, Snowflake ha recentemente annunciato una partnership ampliata con NVIDIA che prevede l’integrazione della piattaforma accelerata full-stack di NVIDIA con il Data Cloud di Snowflake per offrire una combinazione sicura di infrastrutture e capacità di calcolo volta a sbloccare la produttività dell’IA.