La startup francese Mistral AI apre al pubblico e crea un “pool” di IA esperte

Mistral AI, startup francese fondata sette mesi fa da alcuni ex ricercatori di Meta e Google, ha raccolto recentemente finanziamenti per 385 milioni di euro, e ora l’azienda, formata da sole 22 persone, è valutata circa 2 miliardi di dollari. Tra gli investitori figurano le società di venture capital della Silicon Valley Andreessen Horowitz e Lightspeed Venture Partners.

Il valore della start-up è aumentato di oltre sette volte in soli sei mesi, considerando che in estate (dopo un primo round di finanziamenti di 105 milioni di euro) la valutazione di Mistral AI era di circa 260 milioni di dollari. Al cuore dell’offerta di questa start-up c’è lo sviluppo di una tecnologia che altre aziende possono utilizzare per implementare chatbot, motori di ricerca, tutor online e altri prodotti basati sull’intelligenza artificiale.

Mistral AI, a differenza di colossi come OpenAI e Google, è anche tra le aziende che credono nella condivisione dell’IA come software open-source (stesso approccio seguito da un’altra startup molto chiacchierata come Perplexity), fornendo ai non addetti ai lavori tutto ciò di cui hanno bisogno per costruire rapidamente chatbot propri. Anche per questo motivo, Mistral AI è molto considerata in patria e, forse unicum europeo, è ritenuta in grado di sfidare i colossi della Silicon Valley nel campo dell’IA generativa.

Mistral AI è stata fondata da Timothée Lacroix e Guillaume Lample, che in precedenza hanno lavorato come ricercatori nel laboratorio IA di Parigi di Meta, e da Arthur Mensch, che è stato ricercatore presso DeepMind, un laboratorio IA che Google ha acquisito nel 2014 per 650 milioni di dollari.

“Crediamo che l’IA debba essere aperta” ha dichiarato Anjney Midha, partner generale di Andreessen Horowitz che ha guidato il nuovo investimento in Mistral. “La maggior parte delle principali tecnologie che guidano l’informatica moderna è open source, compresi i sistemi operativi per computer, i linguaggi di programmazione e i database”.

Midha ha anche affermato che condividere ampiamente il codice di software IA è la strada più sicura perché più persone possono esaminare la tecnologia, individuarne i difetti e lavorare per rimuoverli o ridurli. “Nessun team di ingegneri è in grado di trovare tutti i bug”, ha affermato. “Le grandi comunità di persone sono più brave a costruire software più economici, più veloci, migliori e più sicuri”.

Scendendo più nel dettaglio del portfolio di Mistral AI, la piattaforma proprietaria offre modelli generativi aperti agli sviluppatori fornendo opzioni di distribuzione e personalizzazione per la produzione. L’accesso beta ai servizi iniziali della piattaforma comprende tre endpoint di chat per la generazione di testi basati su istruzioni testuali e un endpoint di embedding, ciascuno con prestazioni e prezzi diversi.

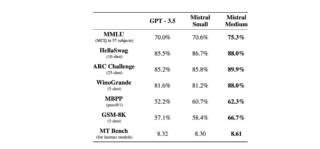

Gli endpoint generativi includono Mistral-tiny, Mistral-small e Mistral-medium. Mistral-tiny è il più economico e utilizza Mistral 7B Instruct v0.2 per l’inglese con un punteggio di 7,6 su MT-Bench. Mistral-small utilizza Mixtral 8x7B per inglese/francese/italiano/tedesco/spagnolo e codice, ottenendo un punteggio di 8,3 su MT-Bench. Mistral-medium, l’endpoint di qualità più elevata, distribuisce un modello in fase prototipale che padroneggia più lingue e codice, ottenendo un punteggio di 8,6 su MT-Bench.

Inoltre, Mistral-embed, l’endpoint di embedding, fornisce un modello con una dimensione di embedding di 1024. L’API segue le specifiche di una popolare interfaccia di chat e include librerie client Python e Javascript. Gli utenti possono impostare un livello più alto di moderazione sugli output del modello fornendo un prompt al sistema.

Da segnalare infine Mixtral 8x7B, uno sparse mixture of experts model (SMoE) open-weight di alta qualità rilasciato sotto licenza Apache 2.0. Mixtral supera Llama 2 70B nella maggior parte dei benchmark con un’inferenza 6 volte più veloce ed è anche il miglior modello in assoluto per quanto riguarda il compromesso costi/prestazioni. In particolare, eguaglia o supera GPT3.5 nella maggior parte dei benchmark standard, gestisce un contesto di 32k token, supporta inglese, francese, italiano, tedesco e spagnolo, mostra ottime prestazioni nella generazione del codice e può essere perfezionato in un modello che segue le istruzioni e che raggiunge un punteggio di 8,3 su MT-Bench.