Oltre 3 organizzazioni su 10 usano strumenti per la sicurezza dell’IA generativa

Il 34% delle organizzazioni sta già utilizzando o implementando strumenti per la sicurezza delle applicazioni di IA generativa (GenAI). È quanto emerge da una nuova indagine di Gartner, secondo la quale anche oltre la metà (56%) degli intervistati sta esplorando tali soluzioni.

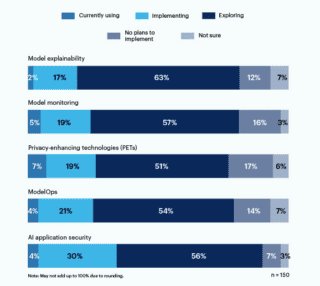

L’indagine della Peer Community di Gartner è stata condotta dal 1° al 7 aprile tra 150 leader del settore IT e della sicurezza informatica di organizzazioni in cui l’IA generativa è in uso, in progetto o in fase di studio. Il 26% di coloro che hanno risposto al sondaggio ha dichiarato che attualmente sta implementando o utilizzando tecnologie di rafforzamento della privacy (PET), ModelOps (25%) o monitoraggio dei modelli (24%).

“Oltre a implementare gli strumenti di sicurezza, i responsabili dell’IT e della sicurezza e gestione del rischio devono prendere in considerazione il supporto di una strategia a livello aziendale per l’AI TRiSM (gestione della fiducia, del rischio e della sicurezza)” ha dichiarato Avivah Litan, Distinguished VP Analyst di Gartner. “L’AI TRiSM gestisce i flussi di dati e processi tra gli utenti e le aziende che ospitano i modelli di base dell’IA generativa e deve essere uno sforzo continuo, non un esercizio una tantum, per proteggere costantemente un’organizzazione”.

Organizzazioni che utilizzano o prevedono di utilizzare strumenti per affrontare i rischi legati all’IA generativa (percentuale di intervistati)

L’IT è responsabile in ultima istanza della sicurezza dell’IA generativa

Sebbene il 93% dei responsabili IT e della sicurezza intervistati abbia dichiarato di essere almeno in qualche modo coinvolto nelle attività di sicurezza e gestione del rischio GenAI della propria organizzazione, solo il 24% ha dichiarato di avere la responsabilità di questa attività. Tra gli intervistati che non hanno la responsabilità della sicurezza GenAI e/o della gestione dei rischi, il 44% ha dichiarato che la responsabilità ultima della sicurezza GenAI spetta all’IT. Per il 20% degli intervistati, la responsabilità spetta invece ai dipartimenti di governance, rischio e conformità dell’organizzazione.

I rischi associati alla GenAI sono significativi, continui e in continua evoluzione. Gli intervistati hanno indicato che i risultati indesiderati e il codice non sicuro sono tra i rischi principali che corrono quando utilizzano GenAI:

- Il 57% degli intervistati è preoccupato per le fughe di segreti nel codice generato dall’IA

- Il 58% degli intervistati è preoccupato per i risultati errati o distorti

“Le organizzazioni che non gestiscono il rischio dell’IA vedranno i loro modelli non funzionare come previsto e, nel peggiore dei casi, potranno causare danni a persone o cose”, conclude Litan. “Questo si tradurrà in fallimenti della sicurezza, perdite finanziarie e reputazionali e danni alle persone a causa di risultati errati, manipolati, non etici o distorti. Le prestazioni errate dell’intelligenza artificiale possono anche indurre le organizzazioni a prendere decisioni aziendali sbagliate“