Un terzo delle aziende carica informazioni personali nelle app di GenAI, e questo è un problema

Netskope ha divulgato i risultati di uno studio recente secondo cui oltre un terzo dei dati riservati condivisi con sistemi di GenAI sono soggetti a normative, esponendo le imprese a potenziali e costose infrazioni della privacy.

L’analisi evidenzia che il 75% delle società intervistate ora impedisce completamente l’accesso ad almeno un’applicazione di GenAI, dimostrando la preoccupazione dei dirigenti IT aziendali riguardo alla possibile fuoriuscita di informazioni personali. Tuttavia, poiché solo una minoranza delle organizzazioni implementa misure di sicurezza focalizzate sui dati per evitare la condivisione di contenuti riservati nelle richieste degli utenti, la maggior parte rimane indietro nell’adozione di soluzioni avanzate per prevenire la dispersione di dati (DLP), essenziali per un utilizzo sicuro dell’IA generativa.

Analizzando dati su scala globale, i ricercatori hanno rilevato che il 96% delle aziende fa uso di GenAI, una cifra triplicata nell’ultimo anno. In media, le imprese ora impiegano quasi 10 applicazioni di IA generativa, rispetto alle 3 dell’anno precedente, con l’1% degli utenti che ora utilizza mediamente 80 applicazioni, in aumento dalle 14 precedenti. Con l’incremento dell’utilizzo, le aziende hanno notato un aumento della condivisione di codice sorgente proprietario all’interno delle applicazioni di GenAI, che rappresenta il 46% di tutte le violazioni documentate delle politiche DLP. Questi cambiamenti complicano la gestione del rischio per le aziende, suggerendo la necessità di un approccio più robusto alla prevenzione della perdita di informazioni personali quando si parla di GenAI.

La ricerca mostra inoltre che un efficace supporto agli utenti ha avuto un ruolo determinante nel mitigare i rischi relativi ai dati, spingendo il 57% degli utenti a modificare il proprio comportamento dopo aver ricevuto avvisi. Lo studio di Netskope ha evidenziato anche i seguenti risultati:

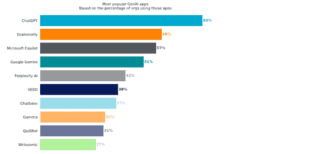

- ChatGPT rimane l’applicazione più diffusa, utilizzata da oltre l’80% delle aziende

- Microsoft Copilot ha registrato la crescita più significativa nell’utilizzo dal suo debutto nel gennaio 2024, raggiungendo il 57%

- Il 19% delle organizzazioni ha imposto un divieto totale su GitHub CoPilot

Netskope suggerisce alle imprese di esaminare, adattare e personalizzare i propri modelli di gestione del rischio specificamente per l’intelligenza artificiale o la GenAI, utilizzando iniziative come il framework di gestione del rischio AI del NIST. Le azioni specifiche per affrontare il rischio derivante dalla GenAI includono:

- Valutare la situazione attuale: esaminare gli usi esistenti dell’intelligenza artificiale e del machine learning, dei flussi di dati e delle applicazioni di GenAI. Identificare le vulnerabilità e le carenze nei controlli di sicurezza

- Implementare controlli di base: stabilire misure di sicurezza fondamentali, come controlli di accesso, meccanismi di autenticazione e crittografia

- Pianificare controlli avanzati: oltre alle misure di base, sviluppare un piano per controlli di sicurezza più sofisticati. Considerare l’analisi delle minacce, il rilevamento delle anomalie, il monitoraggio continuo e l’analisi comportamentale per identificare movimenti sospetti di dati negli ambienti cloud verso le applicazioni di IA generativa che si discostano dai normali modelli di utilizzo

- Valutare, avviare, rivedere, ripetere: esaminare regolarmente l’efficacia delle misure di sicurezza. Adattarle e perfezionarle in base alle esperienze concrete e alle nuove minacce emergenti