Prestazioni IA super con la prossima versione del framework Nvidia NeMo

L’evoluzione e la crescente complessità dei modelli linguistici di grandi dimensioni (LLM) e la necessità di prestazioni di addestramento efficienti nell’ambito dell’intelligenza artificiale sono elementi che un colosso come Nvidia conosce bene. Proprio il framework Nvidia NeMo, un sistema cloud-nativo end-to-end progettato per creare, personalizzare e distribuire modelli generativi di intelligenza artificiale, ha dimostrato la sua efficacia contribuendo alle elevate prestazioni del modello GPT-3 175B, ottenendo risultati impressionanti nei recenti benchmark MLPerf Training di Nvidia con velocità fino a 797 TFLOPS per GPU H100.

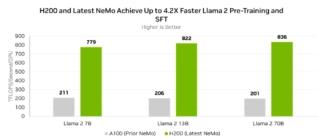

La prossima versione di NeMo, prevista per gennaio 2024, includerà una serie di ottimizzazioni e nuove funzionalità indirizzate a migliorare le prestazioni dei modelli NVIDIA AI Foundation, compresi Llama 2, Nemotron-3 e altri LLM. Queste ottimizzazioni si concentrano su diversi aspetti del framework, tra cui precisione mista, algoritmi di rotary positional embedding (RoPE) e funzioni di attivazione Swish-Gated Linear Unit (SwiGLU). Inoltre, sono stati introdotti miglioramenti significativi nella comunicazione per il parallelismo Tensor Core, contribuendo a raggiungere fino a 836 TFLOPS per GPU H200 nel pre-addestramento e nella messa a punto supervisionata di Llama 2 70B, su GPU basate sull’architettura NVIDIA Hopper.

Miglioramenti sono stati apportati anche al supporto per il Fully Sharded Data Parallelism (FSDP). L’FSDP è riconosciuto come una caratteristica popolare e ben consolidata nella comunità del deep learning, nonché particolarmente adatta per affrontare le sfide derivanti dalle elevate esigenze di calcolo e memoria dei moderni LLM. La sua flessibilità e facilità di utilizzo ne fanno una scelta ideale per la gestione di reti neurali regolari o irregolari, contribuendo a una maggiore usabilità e a una perdita minima di prestazioni in una varietà di situazioni.

Nvidia ha anche sottolineato il supporto ufficiale di NeMo per le architetture basate su Mixture of Experts (MoE) con elevato parallelismo. Questa implementazione, simile a Balanced Assignment of Experts (BASE), consente agli sviluppatori di sfruttare il parallelismo elevato in combinazione con altre dimensioni di parallelismo offerte da NeMo, come il parallelismo dei tensor, delle pipeline e delle sequenze. Ciò rende più agevole l’addestramento di modelli con oltre un trilione di parametri su cluster con molte GPU Nvidia.

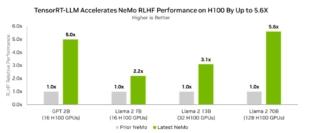

Da segnalare anche il miglioramento del supporto di NeMo per l’apprendimento per rinforzo dal feedback umano (RLHF) con l’introduzione di TensorRT-LLM. Questa implementazione accelera la fase di inferenza del modello attore nel ciclo RLHF, migliorando le prestazioni complessive. L’utilizzo di TensorRT-LLM nel loop RLHF con le GPU H100 può portare a un aumento delle prestazioni fino a 5,6 volte rispetto a RLHF senza TensorRT-LLM.

NeMo è reso disponibile come libreria open-source su GitHub e come componente di NVIDIA AI Enterprise, una piattaforma software di AI di livello enterprise.