Una ricerca di Google punta a estendere all’infinito il contesto degli LLM

Un recente studio condotto da ricercatori di Google ha introdotto una tecnica innovativa denominata Infini-attention, che promette di rivoluzionare il modo in cui i modelli di linguaggio di grandi dimensioni (LLM) gestiscono i testi. Questa tecnologia permette infatti ai modelli di lavorare con testi di lunghezza teoricamente infinita, mantenendo costanti i requisiti di memoria e di calcolo.

La “finestra di contesto” di un modello linguistico rappresenta il numero di token che il modello può elaborare in un dato momento. Tradizionalmente, se una conversazione supera questa finestra, le prestazioni del modello diminuiscono notevolmente e i token iniziali vengono scartati. Infini-attention estende questa finestra di contesto senza aumentare la memoria necessaria, permettendo al modello di mantenere un’alta qualità di elaborazione su sequenze di oltre un milione di token.

L’architettura di Infini-attention si basa sulla struttura Transformer, che è comunemente utilizzata negli LLM ed è nota per la sua “complessità quadratica” in termini di impronta di memoria e tempo di calcolo. Questo significa che aumentare la dimensione dell’input da 1.000 a 2.000 token non raddoppia ma quadruplica i requisiti di memoria e calcolo a causa del meccanismo di self-attention, che confronta ogni elemento della sequenza di input con tutti gli altri elementi.

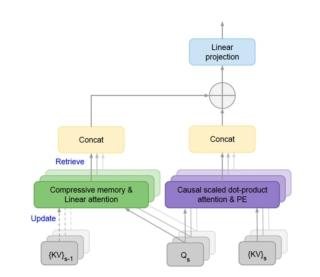

Per superare questa limitazione, Infini-attention integra un modulo di “memoria compressiva” che gestisce gli input estesi. Quando l’input supera la lunghezza del contesto, il modello archivia i vecchi stati di attenzione nella memoria compressiva, che mantiene un numero costante di parametri di memoria per l’efficienza computazionale. Per calcolare l’output finale, Infini-attention aggrega la memoria compressiva e i contesti di attenzione locale.

Questa modifica sottile ma critica al livello di attenzione di Transformer permette una naturale estensione degli LLM esistenti a contesti infinitamente lunghi attraverso un continuo pre-training e fine-tuning. I ricercatori hanno testato Infini-attention su benchmark che valutano gli LLM su sequenze di input molto lunghe. In questi test, Infini-attention ha superato altri modelli a lungo contesto mantenendo punteggi di perplexity più bassi (una misura della coerenza del modello) e richiedendo 114 volte meno memoria.

In termini di applicazioni pratiche, gli LLM a lungo contesto sono cruciali per la personalizzazione delle applicazioni IA. Attualmente, personalizzare gli LLM per applicazioni specifiche richiede tecniche come il fine-tuning o la generazione aumentata da recupero (RAG). Tuttavia, un LLM con contesto infinito potrebbe teoricamente permettere l’inserimento di tutti i documenti desiderati nel prompt, lasciando al modello il compito di selezionare le parti più rilevanti per ogni query. Questo potrebbe anche facilitare la personalizzazione del modello fornendo una lunga lista di esempi per migliorare le sue prestazioni su compiti specifici senza la necessità di un fine-tuning.

Nonostante i potenziali benefici, il contesto infinito non sostituirà altre tecniche, ma abbasserà la barriera all’ingresso per le applicazioni, permettendo agli sviluppatori e alle organizzazioni di creare rapidamente prototipi funzionanti per le loro applicazioni senza enormi sforzi ingegneristici. Le organizzazioni dovranno comunque ottimizzare i loro pipeline LLM per ridurre i costi e migliorare velocità e accuratezza.